Monte Carlo Simulationen, oft auch einfach als Monte-Carlo-Methoden bezeichnet, sind eine leistungsstarke und vielseitige Klasse von Berechnungsverfahren, die zur Lösung einer Vielzahl komplexer Probleme eingesetzt werden. Diese Methoden sind nach dem Monte-Carlo-Kasino in Monaco benannt, das für seine Glücksspiele bekannt ist, da sie sich auf den Zufall und probabilistische Stichproben stützen, um Lösungen für Probleme anzunähern, die deterministischer oder stochastischer Natur sein können. Monte Carlo Simulationen finden in den verschiedensten Bereichen Anwendung, von der Physik und dem Finanzwesen bis hin zur Statistik und dem maschinellen Lernen, was sie zu einem unverzichtbaren Werkzeug für Wissenschaftler, Ingenieure, Analysten und Forscher macht.

In diesem Artikel begeben wir uns auf eine Reise durch die faszinierende Welt der Monte Carlo Simulationen. Wir befassen uns mit den Prinzipien, die diesen Techniken zugrunde liegen, verstehen, wie sie Zufallsstichproben nutzen, und entdecken ihre Effektivität bei der Lösung von Problemen, die früher als unlösbar galten. Von der Schätzung komplexer Integrale bis zur Optimierung von Finanzportfolios, vom Training anspruchsvoller maschineller Lernmodelle bis zur Entschlüsselung der Geheimnisse der Quantenphysik – Monte-Carlo-Methoden bieten einen flexiblen und effizienten Ansatz zur Bewältigung einer Vielzahl von Herausforderungen.

Was sind Monte Carlo Simulationen?

Monte Carlo Simulationen sind eine faszinierende und vielseitige Klasse von Berechnungstechniken, die in zahlreichen Bereichen wie Finanzen, Physik, Technik und Statistik Anwendung finden. Diese Methoden beruhen auf dem Kernkonzept des Zufalls und wurden entwickelt, um Näherungslösungen für Probleme zu finden, die oft zu komplex oder unpraktisch sind, um sie mit traditionellen analytischen Methoden zu lösen. Die Erkundung der Grundlagen der Monte-Carlo-Methoden ist wie das Öffnen eines Tores zur Welt der probabilistischen Problemlösung.

Im Kern ist Monte Carlo vom Zufall inspiriert. Der Name selbst ist eine Hommage an das berühmte Monte-Carlo-Kasino in Monaco, das für seine Glücksspiele bekannt ist, und unterstreicht die zentrale Rolle des Zufalls in diesen Techniken. Bei Monte Carlo Simulationen wird der Zufall als Werkzeug genutzt, um komplizierte Größen abzuschätzen, verschiedene Szenarien zu untersuchen oder anspruchsvolle Probleme zu lösen.

Monte Carlo Simulationen beginnen in der Regel mit der Erzeugung von Zufallsstichproben oder Eingaben. Diese Stichproben werden oft aus bestimmten Wahrscheinlichkeitsverteilungen gezogen, die die inhärente Unsicherheit im Kontext des Problems erfassen. Jede Zufallsstichprobe entspricht einem möglichen Zustand oder Szenario innerhalb des untersuchten Systems oder Modells.

Eine grundlegende Anwendung der Monte Carlo Simulation ist die numerische Integration. Anstatt sich auf traditionelle, auf Kalkül basierende Ansätze zur Berechnung definitiver Integrale zu stützen, nutzen Monte Carlo Näherungen Zufallsstichproben. Die Idee ist, zufällige Punkte innerhalb des Integrationsbereichs zu streuen und den durchschnittlichen Funktionswert über diese Punkte zu berechnen. Dieser Durchschnitt dient als Schätzung des Integrals, was besonders bei Funktionen mit komplexen analytischen Lösungen nützlich ist.

Monte-Carlo-Techniken eignen sich besonders gut für die Simulation komplexer Systeme oder Prozesse. Indem man zufällige Eingaben oder Variationen in ein System einführt, kann man dessen Verhalten oder Eigenschaften abschätzen. Dazu gehören die Bestimmung der erwarteten Ergebnisse, die Bewertung von Varianzen oder die Berechnung von Wahrscheinlichkeiten im Zusammenhang mit verschiedenen Szenarien.

Die Stärke der Monte Carlo Simulationen liegt in ihrer bemerkenswerten Flexibilität und breiten Anwendbarkeit. Sie eignen sich hervorragend für Situationen, in denen sich analytische Lösungen als schwierig, kostspielig oder nicht durchführbar erweisen. Monte Carlo Simulationen eignen sich hervorragend für die Lösung von Problemen, die durch Ungewissheit, Variabilität oder inhärente Zufälligkeit gekennzeichnet sind.

Monte-Carlo-Methoden werden in einer Vielzahl von Bereichen und Disziplinen eingesetzt, was ihre Vielseitigkeit unterstreicht:

- Finanzen: Sie helfen bei der Bewertung von Investitionsrisiken, der Preisfindung für Finanzderivate und der Optimierung von Portfolios.

- Physik: Monte Carlo Simulationen werden für die Simulation von Teilcheninteraktionen, die Modellierung von Quantensystemen und das Verständnis des Verhaltens komplexer physikalischer Systeme eingesetzt.

- Ingenieurwesen: Diese Methoden werden zur Analyse der Zuverlässigkeit von Strukturen und Systemen, zur Durchführung probabilistischer Risikobewertungen und zur Optimierung von Konstruktionen eingesetzt.

- Statistik: Im Bereich der Statistik werden Monte Carlo Markov Chain (MCMC)-Techniken für Bayes’sche Schlussfolgerungen eingesetzt, und Simulationen spielen eine zentrale Rolle in statistischen Studien.

- Computergrafik: Monte-Carlo-Methoden erleichtern das Rendern realistischer Bilder, indem sie das Verhalten von Licht und Materialien simulieren, was zur Erstellung visuell beeindruckender Computergrafiken führt.

Wenn Du Dich eingehender mit Monte Carlo SImulationen befasst, wirst Du nicht nur ihre Fähigkeiten bei der Annäherung von Lösungen entdecken, sondern auch ihre Fähigkeit, eine probabilistische Dimension in die Problemlösung einzuführen. Die Eleganz der Monte Carlo Simulationen liegt in ihrer Anpassungsfähigkeit, die sie sowohl für die theoretische Erforschung als auch für die praktische Problemlösung in einer Vielzahl von Bereichen wertvoll macht.

Wie funktioniert die Monte Carlo Simulation?

Die Monte Carlo Simulationsmethode beruht auf den Prinzipien der Zufälligkeit, der statistischen Stichprobenziehung und der numerischen Annäherung. Im Wesentlichen handelt es sich um einen Prozess der

- Definiere das Problem: Beginne damit, das Problem, das Du lösen oder das System, das Du modellieren möchtest, klar zu definieren. Das kann von der Schätzung des Wertes eines komplexen Integrals bis hin zur Simulation des Verhaltens von Finanzmärkten alles sein.

- Bestimme die Eingabevariablen: Bestimme die Eingabevariablen oder Parameter, die das Problem beeinflussen. Dabei kann es sich um Faktoren wie Zinssätze, Materialeigenschaften, Anfangsbedingungen oder andere relevante Parameter handeln.

- Bestimme Wahrscheinlichkeitsverteilungen: Gebe für jede Eingabevariable eine Wahrscheinlichkeitsverteilung an, die ihre Unsicherheit oder Variabilität darstellt. Zu den gängigen Verteilungen gehören Gleichverteilung, Normalverteilung (Gauß), Exponentialverteilung oder auf das Problem zugeschnittene Verteilungen.

- Erzeuge Zufallsstichproben: Erzeuge unter Verwendung der angegebenen Wahrscheinlichkeitsverteilungen eine große Anzahl von Zufallsstichproben für jede Eingabevariable. Diese Stichproben stellen potenzielle Werte für die Variablen dar und geben die dem Problem innewohnende Unsicherheit wieder.

- Führe Simulationen durch: Führe für jede Kombination von Zufallsstichproben die Simulationen oder Berechnungen durch, die das Problem modellieren. Dies kann das Lösen von Gleichungen, die Simulation physikalischer Prozesse oder andere relevante Berechnungen beinhalten.

- Sammle Daten: Zeichne die Ergebnisse der einzelnen Simulationsläufe auf. Dabei kann es sich um die Lösung einer Gleichung, das Verhalten eines physikalischen Systems oder um andere relevante Daten handeln.

- Analysiere die Ergebnisse: Nachdem Du eine ausreichende Anzahl von Simulationen durchgeführt hast, verfügst Du über einen Datensatz mit Ergebnissen. Analysiere diesen Datensatz, um Schlussfolgerungen über das Problem zu ziehen. Zu den üblichen Analysen gehören die Berechnung von Durchschnittswerten, Varianzen, Perzentilen oder anderen relevanten Statistiken.

- Schätze die Lösung: Nutze die statistischen Eigenschaften der gesammelten Daten, um die Lösung zu schätzen oder Vorhersagen über das System zu treffen. Wenn Sie zum Beispiel den Wert eines komplexen Integrals schätzen, kann der Durchschnitt der berechneten Ergebnisse aus den Simulationen als Schätzung dienen.

- Beurteile die Genauigkeit: Bestimme den Grad der Genauigkeit und des Vertrauens in Deine geschätzte Lösung. Dies kann die Berechnung von Konfidenzintervallen, die Durchführung von Sensitivitätsanalysen oder die Bewertung der Konvergenz beinhalten.

- Wiederhole den Vorgang nach Bedarf: Je nach gewünschtem Genauigkeitsgrad kannst Du die Simulation mit weiteren Stichproben oder Iterationen wiederholen. Dadurch kannst Du Deine Schätzung verfeinern und die Genauigkeit der Ergebnisse verbessern.

- Präsentiere die Ergebnisse: Kommuniziere die Ergebnisse und Erkenntnisse Deiner Monte Carlo Simulation, zusammen mit den damit verbundenen Unsicherheiten oder Einschränkungen. Visualisierungswerkzeuge wie Histogramme, Wahrscheinlichkeitsdichte-Diagramme und Sensitivitätsanalysen können hilfreich sein, um die Ergebnisse effektiv zu vermitteln.

Die Monte Carlo Simulationsmethode ist unglaublich vielseitig und kann auf ein breites Spektrum von Problemen in verschiedenen Bereichen angewendet werden. Ihre Stärke liegt in der Fähigkeit, wertvolle Einblicke und Lösungen für komplexe, probabilistische und unsichere Situationen zu liefern, in denen herkömmliche analytische Methoden möglicherweise nicht ausreichen. Durch die Nutzung von Zufälligkeiten und statistischen Stichproben bieten Monte Carlo Simulationen ein leistungsstarkes Werkzeug für die Entscheidungsfindung, Risikobewertung und Problemlösung.

Wie erzeugt man Zufallszahlen für Monte Carlo Simulationen?

Die Generierung von Zufallszahlen ist ein grundlegender Aspekt der Monte-Carlo-Methoden, da sie dem gesamten Simulations- und Schätzungsprozess zugrunde liegt. Bei Monte Carlo Simulationen werden Zufallszahlen verwendet, um Stichproben aus Wahrscheinlichkeitsverteilungen zu ziehen, die unsichere oder variable Eingaben darstellen. Diese Zufallsstichproben werden dann verwendet, um Berechnungen durchzuführen oder das Verhalten eines Systems zu simulieren. Hier findest Du eine detaillierte Erklärung, wie Zufallszahlen für Monte-Carlo-Methoden erzeugt werden:

Techniken zur Erzeugung von Zufallszahlen:

- Pseudozufallszahlengeneratoren (PRNGs): Bei computergestützten Monte Carlo Simulationen werden in der Regel Pseudozufallszahlengeneratoren verwendet, um Zufallszahlen zu erzeugen. PRNGs sind Algorithmen, die Zahlenfolgen erzeugen, die zufällig erscheinen, aber durch einen anfänglichen Seed-Wert bestimmt sind. Bei gleichem Startwert erzeugt ein PRNG die gleiche Zahlenfolge und ist somit reproduzierbar. Beliebte PRNGs sind der Mersenne Twister und der Linear Congruential Generator (LCG).

- Seed-Wert: PRNGs benötigen einen anfänglichen Seed-Wert, um mit der Erzeugung von Zufallszahlen zu beginnen. Durch die Festlegung des Seed-Wertes stellst Du sicher, dass bei jedem Simulationslauf derselbe Satz von Zufallszahlen erzeugt wird. Dies ist entscheidend, um konsistente und reproduzierbare Ergebnisse zu erhalten.

- Gleichmäßige Zufallszahlen: PRNGs erzeugen in der Regel gleichmäßig verteilte Zufallszahlen zwischen 0 und 1. Diese Zahlen können mit Hilfe von Techniken wie der inversen Transformationsstichprobe oder der Box-Muller-Transformation so transformiert werden, dass sie anderen Wahrscheinlichkeitsverteilungen (z. B. Normal-, Exponential- oder benutzerdefinierten Verteilungen) entsprechen.

- Zufallsstichproben: Sobald Du über einheitliche Zufallszahlen verfügst, kannst Du diese für Stichproben aus verschiedenen Wahrscheinlichkeitsverteilungen verwenden. Wenn Du zum Beispiel normalverteilte Zufallszahlen benötigst, kannst Du die Box-Muller-Transformation auf Ihre gleichmäßigen Zufallsstichproben anwenden.

- Monte-Carlo-Integration: Bei numerischen Integrationsproblemen spielen Zufallszahlen eine entscheidende Rolle bei der Approximation des Integrals einer Funktion. Bei der Monte-Carlo-Integration werden Zufallsstichproben von Punkten innerhalb des Integrationsbereichs gezogen und diese Stichproben zur Schätzung des Integrals verwendet. Je mehr Zufallsstichproben Du erzeugst, desto genauer wird Deine Schätzung.

- Random Walks: Monte Carlo Simulationen verwenden auch Zufallszahlen für Prozesse wie Random Walks, bei denen sich ein Teilchen oder ein System bei jedem Schritt auf der Grundlage probabilistischer Entscheidungen zufällig bewegt. Random Walks werden zur Modellierung von Phänomenen wie Diffusion, Aktienkursbewegungen und Partikelverhalten verwendet.

- Parallelität: Bei vielen Monte Carlo Simulationen ist eine große Anzahl von Stichproben erforderlich, um genaue Ergebnisse zu erhalten. Parallele Rechentechniken können eingesetzt werden, um Zufallszahlen gleichzeitig auf mehreren Prozessoren oder Threads zu generieren, wodurch der Simulationsprozess erheblich beschleunigt wird.

- Testen und Überprüfen: Es ist von entscheidender Bedeutung zu überprüfen, ob die von PRNGs erzeugten Zufallszahlen die gewünschten statistischen Eigenschaften aufweisen. Statistische Tests wie der Kolmogorov-Smirnov-Test und der Chi-Quadrat-Test können helfen, die Zufälligkeit und Einheitlichkeit der generierten Zahlen sicherzustellen.

Zusammenfassend lässt sich sagen, dass die Erzeugung von Zufallszahlen für Monte-Carlo-Methoden die Verwendung von Pseudozufallszahlengeneratoren, einen anfänglichen Startwert und Transformationen zur Anpassung an die gewünschten Wahrscheinlichkeitsverteilungen erfordert. Diese Zufallszahlen sind unerlässlich für die Durchführung von Simulationen, die Annäherung von Integralen, die Modellierung von Zufallsprozessen und die Erstellung von Wahrscheinlichkeitsschätzungen in einer Vielzahl von Anwendungen, von Finanzen und Technik bis hin zu Physik und Statistik. Um die Genauigkeit und Zuverlässigkeit von Monte Carlo Simulationen zu gewährleisten, ist eine sorgfältige Betrachtung der Zufallszahlengenerierung unerlässlich.

Wie werden Monte-Carlo-Methoden beim maschinellen Lernen eingesetzt?

Monte-Carlo-Methoden haben beim maschinellen Lernen wertvolle Anwendungen gefunden. Sie ermöglichen die Erkundung komplexer, hochdimensionaler Räume und die Lösung von Problemen, die analytisch nicht lösbar sind. Hier finden Sie einen umfassenden Überblick über die Verwendung von Monte-Carlo-Methoden in verschiedenen Bereichen des maschinellen Lernens:

- Bayes’sche Inferenz:

Die Bayes’sche Inferenz ist beim maschinellen Lernen von grundlegender Bedeutung für die Schätzung von Wahrscheinlichkeitsverteilungen über Modellparameter, was besonders wertvoll ist, wenn es um Unsicherheit geht. Monte-Carlo-Methoden wie Markov Chain Monte Carlo (MCMC) werden in diesem Zusammenhang häufig eingesetzt. MCMC-Techniken wie Metropolis-Hastings und Gibbs-Sampling ermöglichen es den Praktikern, komplexe, hochdimensionale Parameterräume zu erforschen und Posterior-Verteilungen zu schätzen. Diese Methoden finden Anwendung in der Bayes’schen Modellierung, die Parameterschätzung, Modellauswahl und Quantifizierung der Unsicherheit umfasst.

Nehmen wir zum Beispiel die lineare Bayes’sche Regression. In diesem Szenario können Monte Carlo Simulationen Stichproben aus der posterioren Verteilung der Regressionskoeffizienten ziehen und nicht nur Punktschätzungen, sondern auch glaubwürdige Intervalle liefern, die die Unsicherheit der Parameter erfassen. Diese Informationen sind von unschätzbarem Wert, um fundierte Entscheidungen zu treffen und die Robustheit eines Modells zu bewerten.

- Approximative Inferenz:

Approximative Inferenz wird eingesetzt, wenn eine exakte Inferenz in komplexen Modellen rechnerisch nicht möglich ist. Variational Inference ist ein Monte-Carlo-basierter Ansatz, der komplizierte Posterior-Verteilungen durch einfachere, nachvollziehbare Verteilungen approximiert. Diese Annäherung wird durch Optimierung erreicht, bei der aus der Variationsverteilung Stichproben gezogen werden, um die untere Evidenzgrenze (ELBO) des Modells zu schätzen.

Nehmen wir zum Beispiel Bayessche Neuronale Netze (BNNs). Das Training von BNNs beinhaltet die Schätzung der posterioren Verteilung über die Netzwerkgewichte, die eine hochdimensionale und komplexe Verteilung ist. Variationale Inferenz, die Monte-Carlo-Techniken nutzt, hilft bei der effizienten Annäherung an dieses Posterior. Durch die Optimierung der ELBO können Praktiker eine Bayes’sche Inferenz auf die Gewichte des neuronalen Netzes durchführen, was eine Quantifizierung der Modellunsicherheit und eine Bewertung der Robustheit ermöglicht.

- Integration und Optimierung:

Monte Carlo Simulationen sind bei hochdimensionalen Integrationsaufgaben von unschätzbarem Wert, insbesondere wenn es um komplexe Funktionen oder Zielfunktionen geht, für die es keine geschlossenen Lösungen gibt. Beim Reinforcement Learning beispielsweise, wo die Optimierung von Strategien eine häufige Herausforderung darstellt, kann die Monte-Carlo-Integration zur Schätzung der erwarteten Belohnungen verwendet werden, was die Optimierung von Zielfunktionen ermöglicht.

Außerdem kann Monte-Carlo-Sampling in der Bayes’schen Optimierung eingesetzt werden. Sequentielle modellbasierte Optimierungsalgorithmen (SMBO) verwenden wie die Bayes’sche Optimierung Surrogatmodelle, um Zielfunktionen zu approximieren. Durch Sampling aus den Ersatzmodellen können Praktiker den Parameterraum effizient erkunden, die Anzahl der kostspieligen Auswertungen reduzieren und optimale Hyperparameter für Modelle des maschinellen Lernens finden.

Diese drei Anwendungen verdeutlichen die Vielseitigkeit der Monte-Carlo-Methoden beim maschinellen Lernen. Sie ermöglichen den Anwendern die Handhabung komplexer probabilistischer Modelle, die Durchführung approximativer Inferenzen, die Optimierung von Zielfunktionen und die Quantifizierung von Unsicherheiten und sind damit ein unverzichtbares Werkzeug im Werkzeugkasten des maschinellen Lernens.

Was sind die Grenzen und Herausforderungen von Monte Carlo Simulationen?

Monte-Carlo-Methoden sind unglaublich vielseitige und weit verbreitete Techniken für die Annäherung komplexer Systeme, die Lösung komplizierter Probleme und die Schätzung probabilistischer Ergebnisse. Doch wie jeder Ansatz haben auch sie ihre Grenzen und Herausforderungen, derer sich die Benutzer bewusst sein müssen. Im Folgenden werden einige der wichtigsten Nachteile und Schwierigkeiten im Zusammenhang mit Monte-Carlo-Methoden näher erläutert:

- Berechnungsintensität: Monte-Carlo-Simulationen erfordern oft eine große Anzahl von Stichproben, um präzise und zuverlässige Ergebnisse zu erzielen. Diese Anforderung wird besonders aufwändig, wenn es um hochdimensionale Räume oder komplexe Funktionen geht. Mit zunehmender Anzahl der Stichproben steigen auch die Rechenkosten, was in der Praxis zu einer zeitlichen und finanziellen Einschränkung führen kann.

- Konvergenz-Probleme: Die Geschwindigkeit, mit der Monte Carlo Simulationen zum gewünschten Ergebnis konvergieren, kann je nach mehreren Faktoren erheblich variieren. Dazu gehören die Wahl der Stichprobenmethode, die Komplexität des Problems und die spezifischen Merkmale der zugrunde liegenden Verteilung. Langsame Konvergenzraten können die Fähigkeit behindern, innerhalb eines angemessenen Zeitrahmens genaue Schätzungen zu erhalten.

- Stichprobenverzerrung: Die genaue Erzeugung von Zufallsstichproben, die die Zielverteilung getreu repräsentieren, ist eine grundlegende Herausforderung. Verzerrungen können sich in die Ergebnisse einschleichen, wenn die Stichprobenmethode nicht angemessen konzipiert ist oder wenn sie die Feinheiten der Verteilung nicht erfasst, was zu ungenauen Ergebnissen führen kann.

- Fluch der Dimensionalität: Mit zunehmender Dimensionalität des Problems steigt die Anzahl der für eine zuverlässige Schätzung erforderlichen Stichproben exponentiell an. Dieses Phänomen, das als “Fluch der Dimensionalität” bekannt ist, stellt in hochdimensionalen Räumen eine erhebliche Hürde dar und macht Monte-Carlo-Methoden in solchen Szenarien weniger praktisch.

- Verringerung der Varianz: Eine hohe Varianz in Monte-Carlo-Schätzungen kann problematisch sein, insbesondere bei seltenen Ereignissen oder in Situationen, in denen Präzision von größter Bedeutung ist. Um dieses Problem abzuschwächen, werden häufig Techniken wie Varianzreduzierungsverfahren (z. B. Wichtigkeitsstichproben) eingesetzt. Die Anwendung dieser Techniken kann jedoch die Komplexität der Simulationen erhöhen.

- Wahl der Stichprobentechnik: Die Auswahl der am besten geeigneten Stichprobentechnik ist eine wichtige Entscheidung bei Monte Carlo Simulationen. Die Wahl hängt von den spezifischen Eigenschaften des Problems ab und kann die Genauigkeit und Effizienz der Ergebnisse erheblich beeinflussen. Für diejenigen, die noch nicht mit Monte-Carlo-Techniken vertraut sind, kann die Bestimmung der optimalen Methode eine entmutigende Aufgabe sein.

- Korrelierte Stichproben: Die Korrelation zwischen Stichproben kann die Ergebnisse verzerren und zu Ineffizienzen führen. Dieses Problem ist besonders bei Markov-Chain-Monte-Carlo-Methoden (MCMC) relevant, wo schlecht gewählte Vorschlagsverteilungen zu einer hohen Autokorrelation zwischen den erzeugten Stichproben führen können.

Trotz dieser Einschränkungen und Herausforderungen sind Monte-Carlo-Methoden nach wie vor unverzichtbare Hilfsmittel in verschiedenen Bereichen, darunter Physik, Finanzen, maschinelles Lernen und Technik. Erfahrene Praktiker wissen mit diesen Problemen umzugehen und nutzen die Stärken von Monte-Carlo-Simulationen, um Einblicke in komplexe Systeme zu gewinnen und Probleme anzugehen, die sich analytischen Lösungen entziehen.

Wie kann man Monte Carlo Simulationen in Python implementieren?

Die Implementierung von Monte-Carlo-Methoden in Python kann eine leistungsstarke Methode sein, um komplexe Probleme zu analysieren und zu lösen. In diesem Abschnitt wird ein einfaches Beispiel für die Verwendung von Monte-Carlo-Simulationen zur Schätzung des Wertes von π (pi) anhand eines öffentlich verfügbaren Datensatzes vorgestellt.

Schritt 1: Importieren der erforderlichen Bibliotheken

Zunächst musst Du die erforderlichen Bibliotheken für Ihre Python-Umgebung importieren. In diesem Beispiel werden wir NumPy für numerische Operationen und Matplotlib für die Visualisierung verwenden. Du kannst diese Bibliotheken installieren, falls Du das noch nicht getan hast:

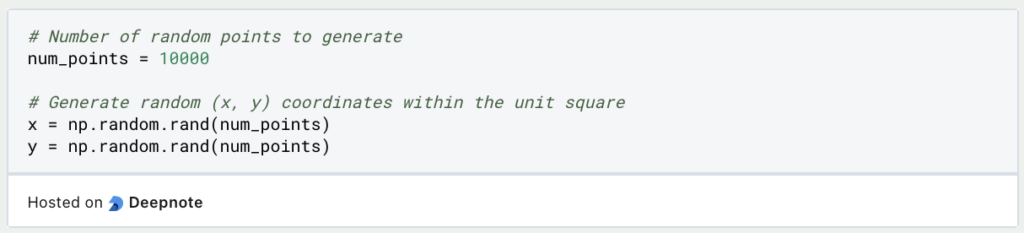

Schritt 2: Erzeugen von Zufallsdaten

Für dieses Beispiel erstellen wir Zufallsdaten innerhalb eines Einheitsquadrats (ein Quadrat mit der Seitenlänge 1), um Punkte innerhalb eines Kreises zu simulieren. Wir werden NumPy verwenden, um zufällige (x, y) Koordinaten zu erzeugen:

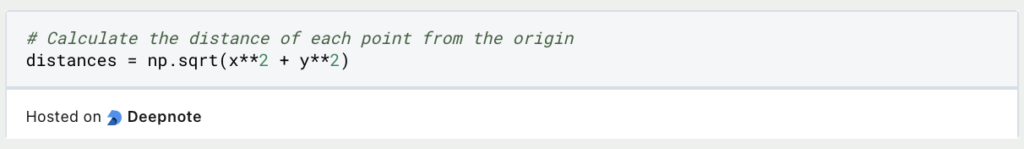

Schritt 3: Berechnen des Abstands vom Ursprung

Nun müssen wir den Abstand der einzelnen Punkte vom Ursprung (0, 0) berechnen. Hierfür können wir die euklidische Abstandsformel verwenden:

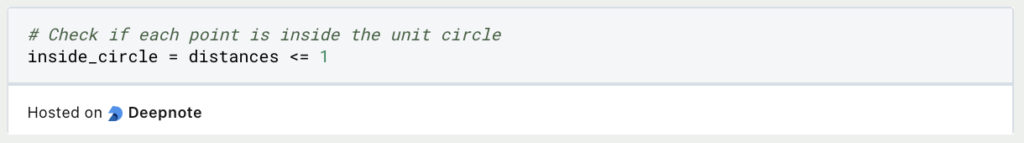

Schritt 4: Prüfen, ob die Punkte innerhalb des Kreises liegen

Um festzustellen, ob jeder Punkt innerhalb des Einheitskreises (Radius 1) liegt, prüfen wir, ob der Abstand vom Ursprung kleiner oder gleich 1 ist:

Schritt 5: Schätzung von π

Nun können wir das Verhältnis der Punkte innerhalb des Kreises zur Gesamtzahl der Punkte verwenden, um den Wert von π zu schätzen. Die Formel für diese Schätzung lautet

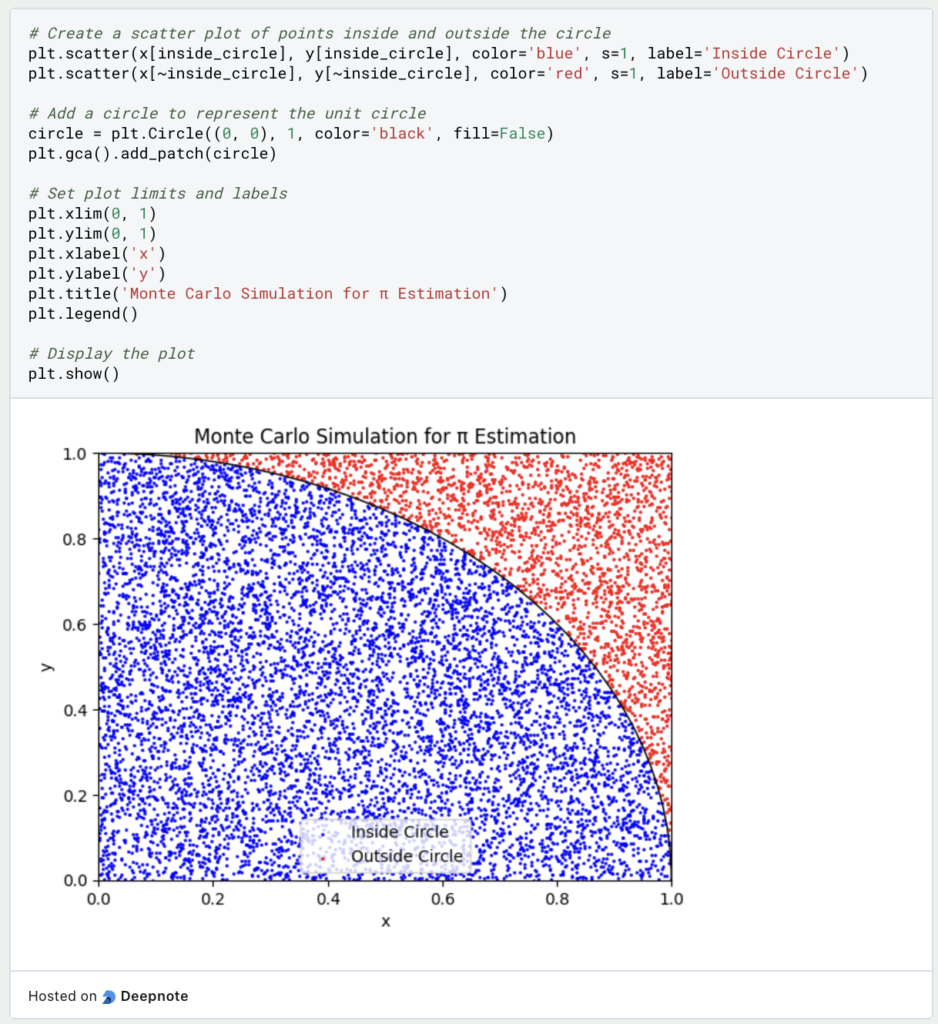

Schritt 6: Visualisierung der Ergebnisse (optional)

Du kannst eine visuelle Darstellung der Monte Carlo Simulation erstellen, indem Du die Punkte innerhalb und außerhalb des Kreises aufzeichnest:

Schritt 7: Drucken der Schätzung

Drucke abschließend den geschätzten Wert von π::

Wenn Du dieses Python-Skript ausführst, kannst Du eine Monte Carlo Simulation durchführen, um den Wert von π zu schätzen. Je mehr Punkte Du generierst (je größer num_points), desto näher kommt Deine Schätzung dem tatsächlichen Wert von π.. Dieses Beispiel zeigt eine grundlegende Anwendung von Monte-Carlo-Methoden, aber sie können auf eine Vielzahl komplexer Probleme angewandt werden, einschließlich Risikobewertung, Optimierung usw.

Das solltest Du mitnehmen

- Monte-Carlo-Methoden sind vielseitig und weithin anwendbar für die Lösung komplexer Probleme in verschiedenen Bereichen, von Finanzen und Technik bis hin zu Physik und maschinellem Lernen.

- Sie bieten einen leistungsstarken Ansatz für die Schätzung numerischer Ergebnisse oder Wahrscheinlichkeiten durch Zufallsstichproben, was sie für Simulationen und Risikobewertungen von unschätzbarem Wert macht.

- Monte Carlo Simulationen ermöglichen die Modellierung realer Szenarien, indem sie Zufälligkeiten und Unsicherheiten in die Analyse einbeziehen, was zu genaueren Vorhersagen führt.

- Trotz ihrer Abhängigkeit von Zufälligkeiten sind Monte-Carlo-Methoden rechnerisch effizient und skalierbar, so dass sie sich für umfangreiche Simulationen und Optimierungsaufgaben eignen.

- Diese Methoden erfordern eine sorgfältige Berücksichtigung von Stichprobengröße, Konvergenz und Rechenressourcen. In hochdimensionalen Räumen oder beim Umgang mit seltenen Ereignissen können sie auch auf Herausforderungen stoßen.

- Monte-Carlo-Techniken spielen in der modernen Technologie eine wichtige Rolle, z. B. im Finanzwesen bei der Preisbildung für Derivate, in der Physik bei der Simulation des Verhaltens von Teilchen und beim maschinellen Lernen für Hyperparameter.

Was ist eine Boltzmann Maschine?

Die Leistungsfähigkeit von Boltzmann Maschinen freisetzen: Von der Theorie zu Anwendungen im Deep Learning und deren Rolle in der KI.

Was ist die Gini-Unreinheit?

Erforschen Sie die Gini-Unreinheit: Eine wichtige Metrik für die Gestaltung von Entscheidungsbäumen beim maschinellen Lernen.

Was ist die Hesse Matrix?

Erforschen Sie die Hesse Matrix: Ihre Mathematik, Anwendungen in der Optimierung und maschinellen Lernen.

Was ist Early Stopping?

Beherrschen Sie die Kunst des Early Stoppings: Verhindern Sie Overfitting, sparen Sie Ressourcen und optimieren Sie Ihre ML-Modelle.

Was sind Gepulste Neuronale Netze?

Tauchen Sie ein in die Zukunft der KI mit Gepulste Neuronale Netze, die Präzision, Energieeffizienz und bioinspiriertes Lernen neu denken.

Was ist RMSprop?

Meistern Sie die RMSprop-Optimierung für neuronale Netze. Erforschen Sie RMSprop, Mathematik, Anwendungen und Hyperparameter.

Andere Beiträge zum Thema Monte Carlo Simulation

Die LMU München hat interessante Vorlesungsfolien zum Thema, die Du hier finden kannst.

Niklas Lang

Seit 2020 bin ich als Machine Learning Engineer und Softwareentwickler tätig und beschäftige mich leidenschaftlich mit der Welt der Daten, Algorithmen und Softwareentwicklung. Neben meiner Arbeit in der Praxis unterrichte ich an mehreren deutschen Hochschulen, darunter die IU International University of Applied Sciences und die Duale Hochschule Baden-Württemberg, in den Bereichen Data Science, Mathematik und Business Analytics.

Mein Ziel ist es, komplexe Themen wie Statistik und maschinelles Lernen so aufzubereiten, dass sie nicht nur verständlich, sondern auch spannend und greifbar werden. Dabei kombiniere ich praktische Erfahrungen aus der Industrie mit fundierten theoretischen Grundlagen, um meine Studierenden bestmöglich auf die Herausforderungen der Datenwelt vorzubereiten.