Data Augmentation bezeichnet einen Prozess um den Trainingsdatensatz zu vergrößern, indem neue, aber realistische Daten erstellt werden. Dazu werden verschiedene Techniken angewandt, um künstliche Datenpunkte aus bestehenden zu generieren.

Was ist Data Augmentation?

In vielen Anwendungsfällen steht man vor dem Problem, dass der Datensatz für Deep Learning Algorithmen schlicht nicht groß genug ist. Dabei ist jedoch vor allem im Bereich des Supervised Learnings das Sammeln von neuen Datenpunkten nicht nur teuer, sondern möglicherweise auch gar nicht möglich.

Wenn wir jedoch einfach neue Datensätze erstellen, kann es auch schnell zu einem Problem mit Overfitting kommen. Aus diesem Grund gibt es verschiedene Techniken im Bereich der Data Augmentation, die sicherstellen, dass das Modell auch wirklich neue Zusammenhänge aus künstlich erstellen Datenpunkten erlernen kann.

In welchen Bereichen sind kleine Datensätze ein Problem?

In den letzten Jahren wurden viele neue Machine Learning und vor allem Deep Learning Architekturen vorgestellt, die außergewöhnliche Performance in verschiedenen Anwendungsfeldern versprechen. Jedoch haben alle diese Architekturen gemein, dass sie viele zu lernende Parameter besitzen. Moderne Neuronale Netzwerke in der Bild- oder Textverarbeitung besitzen schnell mehrere Millionen Parameter. Wenn jedoch der Datensatz nur wenige hundert Datenpunkte hat, reichen diese schlicht nicht aus, um das Netzwerk ausreichend zu trainieren und führen deshalb zu Overfitting. Das bedeutet, dass das Modell lediglich den Datensatz auswendig lernt und somit schlecht generalisiert, also nur schlechte Ergebnisse für neue Daten liefert.

Jedoch ist es gerade in diesen Bereichen, also der Bild- und Textverarbeitung, schwierig und teuer große Datensätze zu bekommen. So gibt es nur vergleichweise wenige Bilder, die konkrete Labels haben, also beispielsweise ob darin ein Hund oder eine Katze zu sehen ist. Zusätzlich kann durch Data Augmentation auch die Performance des Modells besser werden, selbst wenn die Größe des Datensatzes kein Problem ist. Durch die Veränderung des Datensatzes wird das Modell nämlich robuster und lernt auch von Daten, die sich in ihrer Struktur von dem eigentlichen Datensatz unterscheiden.

Welchen Zweck erfüllt Data Augmentation?

Data Augmentation ist ein zentraler Baustein im Machine Learning und Data Science. Das Ziel ist es, den Datensatz durch das Hinzufügen von leicht veränderten Datenpunkten zu vergrößern und außerdem die Leistung des Modells zu verbessern.

In vielen Bereichen sind große und vor allem auch aussagekräftige Datensätze schwer zu finden oder können nur teuer selbst erstellt werden. Mithilfe von Data Augmentation können bestehende Datensätze, die ansonsten möglicherweise zu klein für bestimmte Modellarchitekturen gewesen wären, erweitert werden.

Außerdem bietet Data Augmentation die Möglichkeit das Training des Modells abwechslungsreicher zu gestalten und dadurch eine bessere Generalisierung zu erreichen. Das Modell lernt sich an verschiedene Gegebenheiten anzupassen und unterschiedliche Szenarien zu unterscheiden. Bei der Bildverarbeitung beispielsweise kann es sinnvoll sein Bilder in schwarz-weiß oder aus verschiedenen Blickwinkeln dem Datensatz hinzuzufügen.

Darüber hinaus kann Data Augmentation dazu beitragen, ein Overfitting des Modells zu verhindern. Durch das Hinzufügen von neuen Perspektiven und leicht geänderten Datenpunkten, kann verhindert werden, dass das Modell lediglich das Rauschen der Daten erlernt. Außerdem können mit Data Augmentation auch Klassenungleichgewichte ausgeglichen werden.

Abschließend ist ein weiterer Grund für Data Augmentation die Erstellung von realistischeren oder vielfältigeren Trainingsdaten. Außerdem können Kosten eingespart werden, da weniger Datenpunkt mit einer konkreten Annotation benötigt werden.

Welche Methoden gibt es Daten zu ändern?

Abhängig vom Anwendungsbereich gibt es verschiedene Methoden neue Datenpunkte zu erstellen und dadurch den Datensatz künstlich zu erweitern. Dazu betrachten wir die Bereiche Bild-, Text- und Audioverarbeitung.

Bildverarbeitung

Es gibt verschiedene Anwendungsfälle in denen Machine Learning Modelle Bilder als Input bekommen, beispielsweise zur Bildklassifizierung oder der Erstellung von neuen Bildern. Die Datensätze in diesem Bereich sind meist verhältnismäßig klein und können nur mit großem Aufwand erweitert werden.

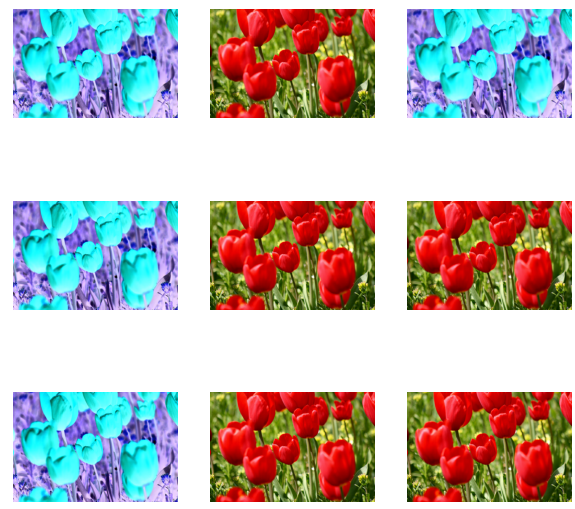

Deshalb gibt es im Bereich der Data Augmentation viele Möglichkeiten einen kleinen Bilddatensatz um ein vielfaches zu vergrößern. Bei der Arbeit mit Bildern sind diese Methoden auch besonders effektiv, da sie dem Modell neue Ansichten ergeben und es somit robuster machen. Zu den häufigsten Methoden in diesem Bereich zählen:

- Geometrische Änderungen: Ein gegebenes Bild kann gedreht, gespiegelt oder ausgeschnitten werden, um aus einem gegebenen Datenpunkt einen neuen zu erstellen.

- Farbliche Änderungen: Durch Änderungen der Helligkeit oder Farben (z.B. schwarz-weiß) kann ein gegebenes Bild verändert werden ohne, dass sich das Label, also z.B. “in dem Bild ist ein Hund zu sehen”, verändert.

- Auflösungsänderung: Scharfe Bilder können gezielt unschärfer gemacht werden, um ein robustes Modell zu trainieren, das die Aufgabe auch mit schlechteren Eingabedaten zuverlässig erfüllen kann.

- Weitere Methoden: Darüber hinaus gibt es noch weitere Methoden zur Veränderung von Bildern, die deutlich aufwändiger sind. Es können zum Beispiel zufällige Teile des Bildes gelöscht werden oder mehrere Bilder mit demselben Label vermischt werden.

Textverarbeitung

Zwar gibt es eine große Menge an Text, die wir beispielsweise auch über das Scraping von Websiten selbst generieren können, jedoch sind diese meist nicht gelabeled und können somit nicht für Supervised Learning genutzt werden. Auch hier gibt es einige einfachere und schwierigere Methoden, um neue Datenpunkte zu erschaffen. Dazu zählen:

- Übersetzung: Die Übersetzung eines Satzes in eine andere Sprache und anschließende Rückübersetzung in die ursprüngliche Sprache liefert neue Sätze und Wörter, die jedoch immer noch denselben Inhalt haben.

- Neuanordnung von Sätzen: Die Anordnung von Sätzen in einem Paragraphen kann verändert werden, ohne dass der Inhalt davon beeinträchtigt wird.

- Austausch von Wörtern: Es können auch gezielt Wörter mit deren Synonymen ausgetauscht werden, um dem Modell einen breiten Wortschatz beizubringen und dadurch robuster zu werden.

Audioverarbeitung

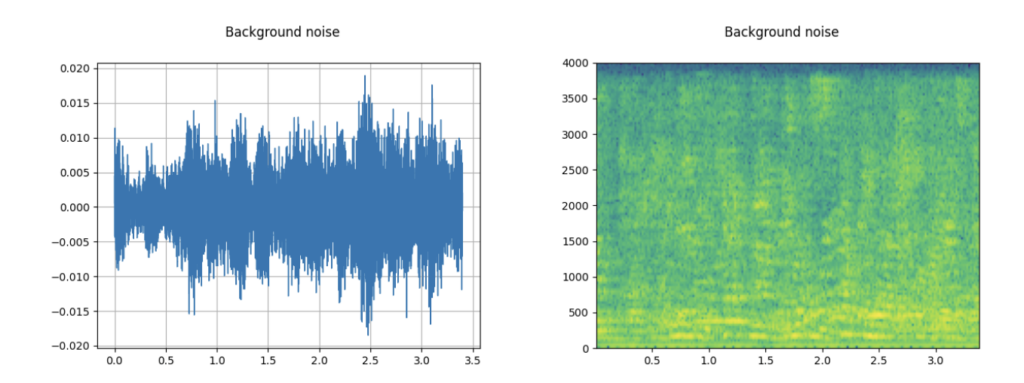

Auch bei der Verarbeitung von Audiodateien kann Data Augmentation vorgenommen werden. In diesem Feld bestehen nämlich ähnliche Probleme wie bei der Textverarbeitung, da Daten für das Supervised Learning nur sehr selten sind. Deshalb haben sich die folgenden Techniken zur Änderung von Datensätzen durchgesetzt:

- Hinzufügen von Noise: Durch das Einarbeiten von Noise in Form von beispielsweise Störgeräuschen können Datenpunkte vervielfacht und der Datensatz somit vergrößert werden.

- Änderung der Geschwindigkeit: Durch die Erhöhung oder Verringerung der Abspielgeschwindigkeit, werden die Machine Learning Modelle robuster und können auch mit schneller gesprochenen Passagen gut umgehen.

Was sind die Vor- und Nachteile von Data Augmentation?

Die Änderung von Datensätzen im Bereich der Data Augmentation kann Vor- und Nachteile in der Anwendung haben.

Zum einen werden performante Modelle heutzutage immer größer und es müssen mehr Parameter trainiert werden. Dadurch läuft man schnell Gefahr, dass der Datensatz zu klein ist und das Modell overfitted, also zu sehr die Eigenschaften des Trainingsdatensatzes auswendig lernt und schlechte auf neue Daten reagiert. Dieses Problem kann durch Data Augmentation gelöst werden. Des Weiteren sind in verschiedenen Anwendungsfällen große Datensätze, vor allem im Bereich des Supervised Learnings, nur mit hohem Ressourceneinsatz zu bekommen. Somit ist eine künstliche Vergrößerung des Datensatzes von Vorteil.

Abgesehen von der Datensatzgröße, führt Data Augmentation oft zu robusteren Modellen, die auch bei unsauberen Daten, beispielsweise mit Störgeräuschen oder schlechter Qualität, noch gute Ergebnisse liefern können. In der Realität kann es mitunter zu Problemen bei der Datenqualität kommen, weshalb robuste Modelle immer von Vorteil sind.

Auf der anderen Seite bedeutet Data Augmentation einen weiteren Schritt im Training eines Modells. Das kann nicht nur Zeit, sondern auch Ressourcen kosten, wenn speicherintensive Daten, wie Bilder oder Videos, verarbeitet werden müssen. Zusätzlich werden die Biases aus dem alten Datensatz übernommen, weshalb die Sicherstellung eines fairen Datensatzes umso wichtiger wird.

Welche Tools und Bibliotheken können für die Data Augmentation genutzt werden?

Es gibt eine große Fülle an Bibliotheken und Werkzeugen, die für die Data Augmentation genutzt werden können. Diese sind spezialisiert auf bestimmte Datentypen und -bereiche und bieten vordefinierte Transformationen, die schnell und einfach genutzt werden können. Hier ist eine Sammlung von einigen beliebten Bibliotheken in diesem Bereich:

Augmentor:

- Augmentor ist eine Bibliothek in Python, die für Data Augmentation im Bereich Bildverarbeitung genutzt werden kann. Sie bietet einfache Möglichkeiten für die Rotation, Spiegelung oder Größenänderung von Bildern.

- Diese Funktionalitäten können mithilfe einer API abgefragt werden. Außerdem können große Datenmengen in kleinen Batches verarbeitet werden und mehrere Transformationen miteinander kombiniert werden.

- Augmentor findet vor allem im Bereich Computer Vision großen Anklang.

ImageDataGenerator (Keras):

- Wenn in Python mit der Deep Learning Plattform Keras gearbeitet wird, ist die Klasse “ImageDataGenerator” ein beliebtes Tool für die Data Augmentation von Bildern.

- Es bietet ähnliche Funktionalitäten wie Augmentor und kann Bilder beispielsweise rotieren, in bestimmte Bereiche hineinzoomen oder spiegeln.

- Der Hauptvorteil dieses Tools ist die nahtlose Integration in Keras, die keinen zusätzlichen Import oder Umstrukturierung der Daten erfordert.

NLTK (Natural Language Toolkit):

- NLTK ist eine Python-Bibliothek, die in der Sprachverarbeitung genutzt wird, um die Texte entsprechend anzupassen.

- Zu den zentralen Funktionalitäten zählen der Austausch von Synonymen oder die Umformulierung von Texten.

OpenCV:

- OpenCV ist eine Python-Bibliothek, die im Bereich der Computer Vision eingesetzt wird.

- Sie bietet eine weitere Möglichkeit, um Bilder zu verarbeiten und anzureichern. Die Funktionalitäten eigenen sich sowohl für einfache als auch für fortgeschrittenere Anwendungen.

TensorFlow Data Augmentation Layers:

- Neben der Keras-API bietet auch TensorFlow die Möglichkeit Data Augmentation in das Modelltraining mit einzubeziehen.

- Im Unterschied zu Keras, kann dabei direkt die sogenannte Data Augmentation Layer in das Modell mit eigefügt werden.

- Diese neuronale Netzwerkschicht ermöglicht die Data Augmentation in Echtzeit während des Modelltrainings. Dadurch wird der Aufwand des Programmierenden in der Datenvorverarbeitung deutlich reduziert.

Librosa:

- Diese Python-Bibliothek wird für Data Augmentation im Bereich der Audio und Musikverarbeitung genutzt.

- Librosa bietet verschiedene Techniken, wie beispielsweise Zeitdehnung, Tonhöhenverbeischung oder die Möglichkeit, Rauschen zur Musik hinzuzufügen.

- Mithilfe dieser Bibliothek lassen sich abwechslungsreiche Datensätze im Bereich der Spracherkennung und Audioklassifikation trainieren.

Benutzerdefinierte Skripte und Pipelines:

- Abhängig von der Anforderungen und den spezifischen Daten kann es sein, dass Data Augmentation auch die Erstellung von eigenen Skripten und Pipelines erfordert.

- Hierbei lassen sich auch verschiedene Bibliotheken kombinieren, beispielsweise wenn man im Bereich der natürlichen Sprachverarbeitung Texte in eine andere Sprache übersetzen und rückübersetzen lässt, um so Data Augmentation zu betreiben.

- Eigene Skripte bieten die Möglichkeit, den Prozess auf die spezifischen Anforderungen des Datensatzes anzupassen.

In Python stehen verschiedene Bibliotheken und Tools zur Verfügung, die bei Data Augmentation helfen können. Diese vereinfachen den Prozess erheblich und ermöglichen es, auf vordefinierte Funktionen zurückzugreifen.

Das solltest Du mitnehmen

- Data Augmentation ist eine Methode bei der ein Datensatz vergrößert wird, indem abgewandelte Datenpunkte nochmals hinzugefügt werden.

- Dadurch kann ein Datensatz vergrößert und das trainierte Modell robuster gemacht werden, da es mit verschiedenen Abwandlungen des Datensatzes umgehen kann.

- Data Augmentation kann in der Bild-, Text- oder auch Audioverarbeitung angewandt werden.

Was ist die Univariate Analyse?

Univariate Analyse beherrschen: Mit Visualisierung und Python tief in Daten eintauchen - Lernen Sie anhand von praktischem Code.

Was ist OpenAPI?

Erkunden Sie OpenAPI: Ein Leitfaden zum Aufbau und zur Nutzung von RESTful APIs. Lernen Sie, wie man APIs entwirft und dokumentiert.

Was ist Data Governance?

Sichern Sie die Qualität, Verfügbarkeit und Integrität der Daten Ihres Unternehmens durch effektives Data Governance. Erfahren Sie mehr.

Was ist Datenqualität?

Sicherstellung der Datenqualität: Bedeutung, Herausforderungen und bewährte Praktiken. Erfahren Sie, wie Sie hochwertige Daten erhalten.

Was ist die Datenimputation?

Imputieren Sie fehlende Werte mit Datenimputationstechniken. Optimieren Sie die Datenqualität und erfahren Sie mehr über die Techniken.

Was ist Ausreißererkennung?

Entdecken Sie Anomalien in Daten mit Verfahren zur Ausreißererkennung. Verbessern Sie ihre Entscheidungsfindung!

Andere Beiträge zum Thema Data Augmentation

- Eine ausführliche Anleitung zu Data Augmentation in TensorFlow findest Du hier.

Niklas Lang

Seit 2020 bin ich als Machine Learning Engineer und Softwareentwickler tätig und beschäftige mich leidenschaftlich mit der Welt der Daten, Algorithmen und Softwareentwicklung. Neben meiner Arbeit in der Praxis unterrichte ich an mehreren deutschen Hochschulen, darunter die IU International University of Applied Sciences und die Duale Hochschule Baden-Württemberg, in den Bereichen Data Science, Mathematik und Business Analytics.

Mein Ziel ist es, komplexe Themen wie Statistik und maschinelles Lernen so aufzubereiten, dass sie nicht nur verständlich, sondern auch spannend und greifbar werden. Dabei kombiniere ich praktische Erfahrungen aus der Industrie mit fundierten theoretischen Grundlagen, um meine Studierenden bestmöglich auf die Herausforderungen der Datenwelt vorzubereiten.