Multikollinearität ist ein statistisches Problem, das auftritt, wenn unabhängige Variablen in einem Regressionsmodell stark miteinander korreliert sind und es somit schwierig ist, den Effekt einer einzelnen unabhängigen Variablen auf die abhängige Variable zu isolieren. Es handelt sich um ein häufiges Problem in der statistischen Analyse und kann zu unzuverlässigen und instabilen Regressionsmodellen führen.

Dieser Artikel untersucht das Konzept der Multikollinearität, ihre Ursachen und Konsequenzen sowie die Erkennung und Behandlung in der Regressionsanalyse. Wir werden auch die Auswirkungen auf die Modellleistung und die Interpretation der Ergebnisse diskutieren.

Was ist Multikollinearität?

Multikollinearität ist ein statistisches Phänomen, das auftritt, wenn zwei oder mehr Prädiktorvariablen in einem Regressionsmodell stark miteinander korreliert sind und es somit schwierig ist, ihre individuellen Effekte auf die Zielvariable zu bestimmen. Mit anderen Worten bedeutet dies eine lineare Beziehung zwischen den unabhängigen Variablen in einem Regressionsmodell.

Dies kann mehrere Probleme in der Analyse verursachen, wie zum Beispiel die Schwierigkeit, die Koeffizienten der Regressionsgleichung zu schätzen, was zu instabilen und unzuverlässigen Schätzungen der Koeffizienten führt, und die Herausforderung, die Ergebnisse der Regressionsanalyse zu interpretieren. Daher ist es wichtig, dieses Problem in der Regressionsanalyse zu identifizieren und anzugehen, um genaue und zuverlässige Ergebnisse zu erhalten.

Was sind die Ursachen von Multikollinearität?

Multikollinearität, das Phänomen, bei dem Prädiktorvariablen in einem Regressionsmodell stark miteinander korreliert sind, kann aus verschiedenen Gründen auftreten. Das Verständnis der Ursachen ist entscheidend, um dieses Problem wirksam zu erkennen und anzugehen.

- Überlappende Variablen: Das Einbeziehen mehrerer Variablen, die ähnliche Aspekte desselben Phänomens messen, kann zu Multikollinearität führen. Zum Beispiel die Verwendung von Höhenangaben in Zoll und Höhenangaben in Zentimetern als Prädiktorvariablen in einem Modell.

- Daten-Transformation: In einigen Fällen kann die Anwendung bestimmter mathematischer Transformationen auf Variablen das Problem einführen. Zum Beispiel das Quadrieren oder Logarithmieren einer Variable, die bereits stark mit einer anderen Prädiktorvariable korreliert ist.

- Kategoriale Variablen: Bei der Verarbeitung kategorialer Variablen kann Multikollinearität auftreten, wenn eine Kategorie durch eine Kombination anderer Kategorien dargestellt wird. Dies wird als Dummy-Variablen-Falle bezeichnet.

- Messfehler: Ungenaue oder unpräzise Messung von Variablen kann zum Problem beitragen. Messfehler, die bei mehreren Variablen konsistent auftreten, können zu hoher Korrelation führen.

- Stichprobenauswahl: Wenn der Datenerhebungsprozess oder die Stichprobenauswahl voreingenommen ist, kann das Problem auftreten. Zum Beispiel die Auswahl einer Stichprobe, die nicht repräsentativ für die Population ist oder das Ausschließen bestimmter Gruppen, kann zu korrelierten Prädiktorvariablen führen.

- Datenaggregation: Das Aggregieren von Daten auf verschiedenen Ebenen kann zu Multikollinearität führen. Zum Beispiel das Einbeziehen von Variablen auf individueller und Gruppenebene in ein Regressionsmodell.

- Interaktionsterme: Das Einbeziehen von Interaktionstermen (Produkt von zwei oder mehr Variablen) kann dieses Problem erzeugen, wenn die beteiligten Variablen bereits korreliert sind.

Die Identifizierung der Ursachen von Multikollinearität kann dazu beitragen, das Problem durch den Einsatz geeigneter Techniken wie Merkmalsauswahl, Daten-Transformation oder die Verwendung von Regularisierungsmethoden wie Ridge Regression zu mildern. Es ist wichtig, die Daten sorgfältig zu analysieren, den Forschungskontext zu berücksichtigen und Fachleute auf dem Gebiet zu konsultieren, um das Problem effektiv anzugehen.

Welche Werkzeuge kannst Du zur Erkennung von Multikollinearität verwenden?

Die Erkennung von Multikollinearität ist ein entscheidender Schritt in der Regressionsanalyse, da sie die Zuverlässigkeit und Genauigkeit der Ergebnisse gewährleistet. Es gibt mehrere Techniken zur Identifizierung in einem Datensatz.

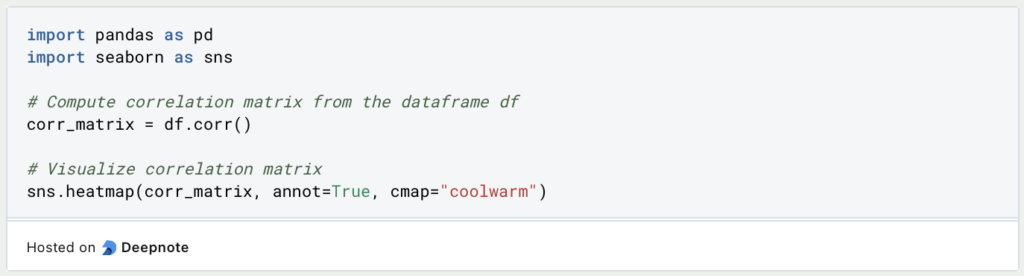

Ein häufig verwendetes Verfahren besteht darin, die Korrelationsmatrix zu berechnen, die die lineare Beziehung zwischen jedem Paar von Prädiktorvariablen misst. Hohe Korrelationskoeffizienten (nahe 1 oder -1) deuten auf eine starke lineare Beziehung hin und können potenziell zu einem Problem führen. Durch die Visualisierung der Korrelationsmatrix mithilfe einer Heatmap erhälst Du einen klaren Überblick über die Korrelationen.

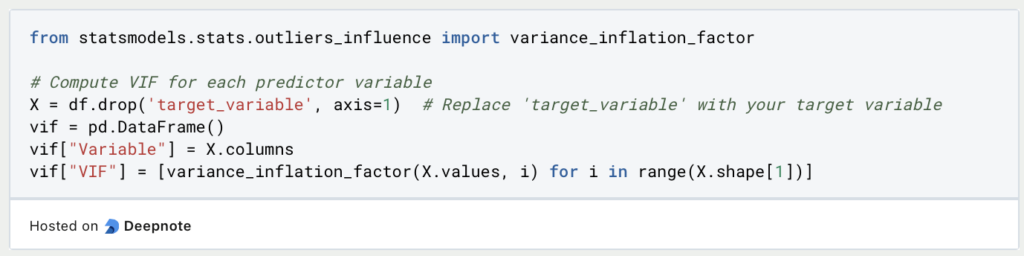

Eine weitere Methode besteht darin, den Variance Inflation Factor (VIF) für jede Prädiktorvariable zu berechnen. Der VIF quantifiziert, wie stark die Varianz eines geschätzten Regressionskoeffizienten aufgrund von Multikollinearität erhöht wird. Höhere VIF-Werte deuten auf eine stärkere Wirkung hin. Variablen mit VIF-Werten über einem bestimmten Schwellenwert, wie zum Beispiel 5 oder 10, können auf Multikollinearität hinweisen.

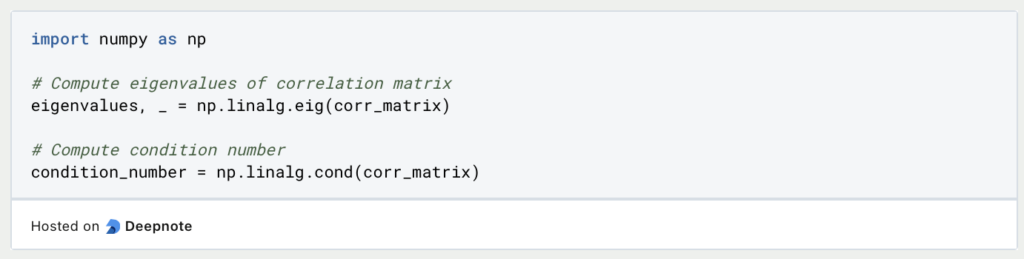

Eigenwerte und die Konditionszahl der Korrelationsmatrix können ebenfalls untersucht werden. Wenn ein oder mehrere Eigenwerte nahe bei Null oder signifikant kleiner als die anderen sind, deutet dies auf das Vorliegen von Multikollinearität hin. Die Konditionszahl, die als Quadratwurzel des Verhältnisses des größten zum kleinsten Eigenwert berechnet wird, gibt Auskunft über die Schwere des Problems. Eine große Konditionszahl (>30) deutet auf hohe Multikollinearität hin.

Auch die Toleranz, die das Reziprok des VIF ist, kann analysiert werden. Variablen mit niedrigen Toleranzwerten (nahe 0) deuten auf hohe Multikollinearität hin. Ebenso kann die Proportion der Varianz, die von jeder Prädiktorvariable erklärt wird, Aufschluss über das Problem geben. Variablen mit geringen Varianzanteilen tragen weniger eindeutige Informationen bei und können mit anderen Prädiktoren korreliert sein.

Die Hauptkomponentenanalyse (PCA) ist eine weitere nützliche Methode. Sie identifiziert lineare Kombinationen von Prädiktorvariablen, die den Großteil der Varianz im Datensatz erklären. Wenn nur wenige Hauptkomponenten einen bedeutenden Teil der Variabilität erfassen, deutet dies auf Multikollinearität hin. Das Erstellen eines Scree-Plots und die Untersuchung des Anteils der erklärten Varianz können bei der Bestimmung der von Multikollinearität betroffenen Anzahl von Hauptkomponenten helfen.

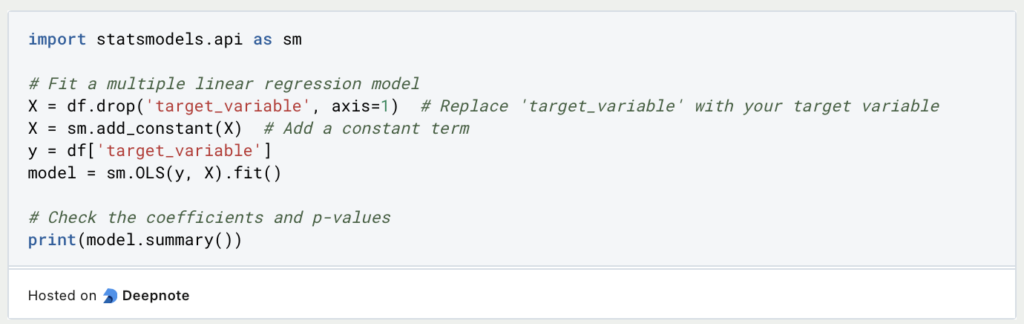

Darüber hinaus können Regressionskoeffizienten und Hypothesentests Erkenntnisse liefern. Große Standardfehler und inkonsistente Vorzeichen der Regressionskoeffizienten können auf Multikollinearität hinweisen. Die Durchführung von Hypothesentests auf die Regressionskoeffizienten kann dazu beitragen, deren Signifikanz und Stabilität zu bewerten.

Obwohl Multikollinearität die Interpretation und Präzision der Koeffizienten beeinflusst, macht sie die gesamte Regressionsanalyse nicht ungültig. Wenn Multikollinearität festgestellt wird, können Strategien wie Merkmalsauswahl, Daten-Transformation oder die Verwendung von Regularisierungstechniken wie Ridge Regression helfen, das Problem zu mildern. Es ist wichtig, domänenspezifisches Wissen und den spezifischen Kontext zu berücksichtigen, um das Problem effektiv anzugehen.

Wie kannst Du Python im Erkennungsprozess einsetzen?

Die Erkennung von Multikollinearität in Python kann mit verschiedenen Methoden erfolgen. In allen Beispielen gehen wir davon aus, dass Sie Ihre Daten in der Variable “df” gespeichert haben, die ein Pandas DataFrame ist. Du kannst diese Beispiele verwenden, indem Du die Platzhalter durch die Namen Deiner spezifischen Spalten ersetzt. Hier werden einige gängige Ansätze besprochen:

- Korrelationsmatrix: Berechne die Korrelationsmatrix der Prädiktorvariablen mithilfe der Funktion corr() aus der Bibliothek pandas. Visualisiere die Korrelationsmatrix mithilfe einer Heatmap, um stark korrelierte Variablen zu identifizieren.

- Varianz-Inflations-Faktor (VIF): Berechne den VIF für jede Prädiktorvariable, um das Ausmaß des Problems zu beurteilen. Höhere VIF-Werte weisen auf eine stärkere Korrelation zwischen den Variablen hin.

- Eigenwerte und Zustandszahl: Analysiere die Eigenwerte der Korrelationsmatrix oder berechne die Bedingungszahl. Wenn die Eigenwerte nahe bei Null liegen oder die Konditionenzahl hoch ist, liegt möglicherweise Multikollinearität vor.

- Regressionsmodelle: Passe ein Regressionsmodell an und untersuche die Koeffizienten und ihre Signifikanz. Große Koeffizienten oder niedrige p-Werte können auf Multikollinearitätsprobleme hinweisen.

Durch Anwendung dieser Techniken kannst Du das Problem in Ihrem Datensatz identifizieren und geeignete Schritte ergreifen, um es zu lösen, bevor Du Regressionsmodelle erstellt. Denke daran, den spezifischen Kontext Deiner Daten und das gewünschte Toleranzniveau zu berücksichtigen.

Welche Auswirkungen hat Multikollinearität auf die Regressionsanalyse?

Multikollinearität kann erhebliche Auswirkungen auf die Ergebnisse einer Regressionsanalyse haben. Wenn zwei oder mehr Prädiktorvariablen stark miteinander korreliert sind, wird es für das Regressionsmodell schwierig zu bestimmen, welche Variable den größten Einfluss auf die abhängige Variable hat. Dies kann zu inkorrekten und instabilen Koeffizientenschätzungen führen und die Interpretation der Analyseergebnisse erschweren.

Ein häufiges Problem besteht darin, dass Multikollinearität zu Koeffizienten mit falschen Vorzeichen oder Größen führen kann. Wenn zum Beispiel zwei Variablen stark miteinander korreliert sind, kann das Regressionsmodell einer Variable einen positiven Koeffizienten und der anderen einen negativen Koeffizienten zuweisen, selbst wenn beide Variablen eine positive Beziehung zur abhängigen Variable haben. Dies liegt daran, dass das Modell den Effekt jeder Variable nicht von dem der anderen unterscheiden kann.

Multikollinearität kann auch zu breiteren Konfidenzintervallen für die Koeffizienten führen, was es schwieriger macht, statistisch signifikante Effekte zu erkennen. Dies kann dazu führen, dass die Fähigkeit zur genauen Vorhersage der abhängigen Variable reduziert wird. Darüber hinaus kann Multikollinearität zu instabilen und inkonsistenten Koeffizienten in verschiedenen Stichproben führen, was es schwierig macht, die Ergebnisse auf andere Populationen zu verallgemeinern.

Es ist wichtig zu beachten, dass das Vorhandensein von Multikollinearität nicht unbedingt bedeutet, dass das Regressionsmodell ungültig ist. Es bedeutet jedoch, dass die Ergebnisse mit Vorsicht interpretiert werden sollten und Anstrengungen unternommen werden sollten, um sie gegebenenfalls zu reduzieren.

Wie werden die Regressionsergebnisse interpretiert, wenn Multikollinearität vorliegt?

In Anwesenheit von Multikollinearität kann die Interpretation der Regressionsergebnisse schwierig werden. Dies liegt daran, dass das Problem die Standardfehler der Regressionskoeffizienten erhöhen und zu instabilen und unzuverlässigen Schätzungen führen kann.

Wenn zwei oder mehr Variablen stark miteinander korreliert sind, kann es schwierig sein, zu bestimmen, welche Variable(n) einen signifikanten Effekt auf die abhängige Variable haben. Als Ergebnis können die Regressionskoeffizienten schwierig zu interpretieren sein, da ihre Werte möglicherweise nicht mit dem übereinstimmen, was wir basierend auf unserem Verständnis der Beziehung zwischen den Prädiktor- und abhängigen Variablen erwarten.

Ein häufiges Problem bei der Interpretation von Regressionsergebnissen in Anwesenheit von Multikollinearität besteht darin, die wichtigsten Prädiktorvariablen zu identifizieren. Die Regressionskoeffizienten können sehr groß sein, aber die Standardfehler können auch sehr groß sein, was es schwierig macht, den tatsächlichen Effekt jeder Prädiktorvariable auf die abhängige Variable zu bestimmen.

Ein weiteres Problem besteht in der Möglichkeit, instabile Regressionskoeffizienten zu erhalten, was zu falschen oder irreführenden Schlussfolgerungen führen kann. Zum Beispiel kann eine Variable, die in einem Modell ohne Multikollinearität einen kleinen, aber signifikanten Effekt auf die abhängige Variable hat, einen großen und insignifikanten Koeffizienten haben.

Insgesamt ist es wichtig, Regressionsergebnisse in Anwesenheit von Multikollinearität sorgfältig zu bewerten und alternative Methoden wie Regularisierungstechniken oder Hauptkomponentenanalyse in Betracht zu ziehen, um das Problem anzugehen.

Welche Beispiele für Probleme durch Multikollinearität gibt es?

Multikollinearität kann verschiedene Probleme in der realen Welt verursachen, und es ist wichtig, diese zu beheben, um genaue Regressionsergebnisse zu erhalten. Hier sind einige Beispiele:

- In der medizinischen Forschung können mehrere Prädiktorvariablen wie Alter, Geschlecht und Krankheitsgeschichte in ein Regressionsmodell einbezogen werden, um das Ergebnis einer Krankheit vorherzusagen. Wenn diese Prädiktorvariablen jedoch stark miteinander korreliert sind, können die Regressionskoeffizienten instabil werden und es wird schwierig, den Effekt jeder Variablen zu bestimmen.

- Im Bereich der Finanzen tritt ein häufiges Problem in der Multikollinearität zwischen den unabhängigen Variablen eines Finanzmodells auf. Zum Beispiel können in einem Modell zur Vorhersage von Aktienkursen mehrere Variablen wie Gewinn pro Aktie, Kurs-Gewinn-Verhältnis und Dividendenrendite stark miteinander korreliert sein. Dies kann zu instabilen Regressionskoeffizienten und ungenauen Vorhersagen führen.

Es gibt mehrere Möglichkeiten, das Problem der Multikollinearität in der Regressionsanalyse zu lösen, wie zum Beispiel:

- Datenbeschaffung: Das Sammeln weiterer Daten kann dazu beitragen, die Korrelation zwischen den unabhängigen Variablen zu verringern und die Genauigkeit des Regressionsmodells zu verbessern.

- Variablenauswahl: Das Entfernen von stark korrelierten Variablen aus dem Modell kann dazu beitragen, die Multikollinearität zu reduzieren und die Stabilität der Regressionskoeffizienten zu verbessern.

- Datentransformation: Die Transformation der Daten durch Standardisierung der Variablen oder Anwendung einer Transformation wie dem logarithmischen oder Wurzel kann dazu beitragen, die Korrelation zwischen den unabhängigen Variablen zu reduzieren.

- Ridge-Regression: Die Ridge-Regression ist eine Technik, die dazu dient, die Regressionskoeffizienten zu bestrafen, was helfen kann, den Einfluss der Multikollinearität zu reduzieren und die Stabilität des Regressionsmodells zu verbessern.

Durch die Behebung des Problems können genaue Regressionsergebnisse erzielt und fundierte Entscheidungen auf der Grundlage der Analyse getroffen werden.

Welche gängigen Missverständnisse gibt es?

Gängige Missverständnisse und Fallstricke im Umgang mit Multikollinearität sind:

- Multikollinearität ignorieren: Ein häufiger Fehler besteht darin, das Problem zu ignorieren und mit der Regressionsanalyse fortzufahren. Dies kann zu unzuverlässigen Ergebnissen und falschen Schlussfolgerungen führen.

- Variablen nur aufgrund hoher Korrelation entfernen: Nur weil zwei Variablen stark miteinander korreliert sind, bedeutet das nicht zwangsläufig, dass sie redundant sind. Es ist wichtig, den Beitrag jeder Variablen zum Modell zu betrachten und ihre Bedeutung zu bewerten.

- Nur paarweise Korrelationen berücksichtigen: Multikollinearität kann auch dann vorhanden sein, wenn es keine paarweisen Korrelationen zwischen den Variablen gibt. Es ist wichtig, die gesamte Korrelationsstruktur der Daten zu berücksichtigen.

- Verwendung von schrittweiser Regression: Schrittweise Regressionsmethoden können zu Instabilität im Modell führen und möglicherweise nicht die Beziehung zwischen den Prädiktoren und der abhängigen Variable genau erfassen.

- Annahme von Kausalität basierend auf Korrelation: Eine hohe Korrelation zwischen Variablen bedeutet nicht zwangsläufig eine kausale Beziehung. Es ist wichtig, die zugrunde liegenden Mechanismen und den Kontext der Variablen sorgfältig zu betrachten.

Um diese Fallstricke zu vermeiden, ist es wichtig, geeignete statistische Methoden zur Erkennung und Behandlung von Multikollinearitäten zu verwenden, wie z.B. Varianzinflationsfaktoren (VIF), Hauptkomponentenanalyse (PCA) oder Ridge-Regression. Es ist auch wichtig, die zugrunde liegende Theorie und den Kontext der Variablen sorgfältig zu berücksichtigen und die Ergebnisse vorsichtig und differenziert zu interpretieren.

Das solltest Du mitnehmen

- Multikollinearität ist ein häufiges Problem bei der Regressionsanalyse, bei der unabhängige Variablen stark miteinander korreliert sind, was zu Problemen bei der Interpretation der Regressionsergebnisse führt.

- Das Vorhandensein von Multikollinearität kann zu überhöhten Standardfehlern, unzuverlässigen Schätzungen der Regressionskoeffizienten und Schwierigkeiten bei der Identifizierung der wichtigsten Prädiktoren führen.

- Multikollinearität kann mit Hilfe von statistischen Methoden wie Korrelationsmatrizen, Varianzinflationsfaktoren (VIF) und Eigenwertzerlegung festgestellt werden.

- Zu den gängigen Strategien für den Umgang mit Multikollinearität gehören das Weglassen einer der korrelierten Variablen, das Kombinieren der Variablen zu einem einzigen Prädiktor und die Verwendung von Techniken zur Dimensionalitätsreduktion wie die Hauptkomponentenanalyse (PCA).

- Zu den Fehleinschätzungen und Fallstricken gehören die Annahme, dass Korrelation zwischen Prädiktoren Multikollinearität impliziert, das Ignorieren des Problems und die Interpretation der Ergebnisse ohne Berücksichtigung der Auswirkungen der Multikollinearität sowie die Verwendung falscher Methoden zur Erkennung und Behandlung des Problems.

- Insgesamt ist es wichtig, Multikollinearität in der Regressionsanalyse zu verstehen und zu berücksichtigen, um genaue und zuverlässige Ergebnisse zu erhalten.

Was ist die Bernoulli Verteilung?

Entdecken Sie die Bernoulli Verteilung: Verstehen Sie die Rolle in der Wahrscheinlichkeitsrechnung und bei der binären Modellierung.

Was ist eine Wahrscheinlichkeitsverteilung?

Wahrscheinlichkeitsverteilungen in der Statistik: Lernen Sie die Arten, Anwendungen und Schlüsselkonzepte der Datenanalyse kennen.

Was ist die F-Statistik?

Erforschen Sie die F-Statistik: Ihre Bedeutung, Berechnung und Anwendungen in der Statistik.

Was ist Gibbs-Sampling?

Erforschen Sie Gibbs-Sampling: Lernen Sie die Anwendungen kennen und erfahren Sie, wie sie in der Datenanalyse eingesetzt werden.

Was ist ein Bias?

Auswirkungen und Maßnahmen zur Abschwächung eines Bias: Dieser Leitfaden hilft Ihnen, den Bias zu verstehen und zu erkennen.

Was ist die Varianz?

Die Rolle der Varianz in der Statistik und der Datenanalyse: Verstehen Sie, wie man die Streuung von Daten messen kann.

Andere Beiträge zum Thema Multikollinearität

Einen ausführlichen Artikel über Multikollinearität von der Universität Kassel findest Du hier.

Niklas Lang

Seit 2020 bin ich als Machine Learning Engineer und Softwareentwickler tätig und beschäftige mich leidenschaftlich mit der Welt der Daten, Algorithmen und Softwareentwicklung. Neben meiner Arbeit in der Praxis unterrichte ich an mehreren deutschen Hochschulen, darunter die IU International University of Applied Sciences und die Duale Hochschule Baden-Württemberg, in den Bereichen Data Science, Mathematik und Business Analytics.

Mein Ziel ist es, komplexe Themen wie Statistik und maschinelles Lernen so aufzubereiten, dass sie nicht nur verständlich, sondern auch spannend und greifbar werden. Dabei kombiniere ich praktische Erfahrungen aus der Industrie mit fundierten theoretischen Grundlagen, um meine Studierenden bestmöglich auf die Herausforderungen der Datenwelt vorzubereiten.