Künstliche Intelligenz beschreibt den Versuch einem Computer menschliches Lernen und Denken beizubringen. Im Unterschied zu einem Algorithmus soll die Maschine auch erlernte Aufgaben lösen können, für die sie nicht direkt programmiert wurde.

Was ist Künstliche Intelligenz?

Der Begriff von Künstlicher Intelligenz gibt es schon länger als es die meisten wahrscheinlich erwarten würden. Bereits 1950 nutzen Alan Turing den Begriff in seiner Seminararbeit “Computing Machinery and Intelligence” und beschäftigte sich unter anderem mit der Frage, ob Maschinen denken können.

Von ihm stammt auch der berühmte “Turing Test”, der ein erster Ansatz war darüber zu entscheiden, ob ein Computer “artificial intelligent” ist. Der Versuchsaufbau dazu ist relativ einfach. Eine Versuchsperson, stellt einer zweiten Versuchsperson und einem Computer verschiedene Fragen innerhalb eines bestimmten Anwendungsbereichs. Anschließend bekommt der fragende Teilnehmer die Antworten zurückgespielt ohne zu wissen, welche von einem Menschen und welche von einem Computer stammt.

Nun muss er versuchen zu entscheiden, welche Antwort menschlich ist und welche nicht. Wenn er in mehr als 50 % der Fälle diese Zuordnung nicht richtig vornehmen kann, zählt der Computer als künstlich intelligent, denn seine Antworten werden in der Hälfte aller Fälle als genauso menschlich angesehen, wie die eines Menschen.

Obwohl die Arbeit von Turing als Grundstein der Entwicklung von Künstlicher Intelligenz gilt, haben sich in den letzten Jahren andere Definitionen in den Vordergrund gedrängt. Das Buch von Stuart Russell und Peter Norvig (Artificial Intelligence, A Modern Approach) hat sich dabei zu einem der literarischen Eckpfeiler entwickelt.

In diesem Buch definieren die Autoren insgesamt vier verschiedene Ziele, welche eine Künstliche Intelligenz in ihren Augen erfüllen sollte:

| Human Approach | Ideal Approach |

|---|---|

| Systeme, die wie Menschen denken | Systeme, die rational denken |

| Systeme, die wie Menschen handeln | Systeme, die rational handeln |

Unabhängig von der Definition von Künstlicher Intelligenz, handelt es sich dabei um ein Teilfeld von Computer Science, das mithilfe von großen Datensätzen und statistischen Methoden versucht Zusammenhänge zu erlernen und auf neue Daten anzuwenden.

Welche Arten von Künstlicher Intelligenz gibt es?

Die sogenannte Narrow AI (auch schwache AI oder Artificial Narrow Intelligence (ANI)) bezeichnet Modelle, die auf einen konkreten Anwendungsfall trainiert sind und für diesen auch sehr gute Ergebnisse erzielen. In diesem speziellen Bereich können sie sogar besser sein als der Mensch. Die meisten KI – Systeme, die uns bereits heute umgeben, werden dem Bereich Narrow AI zugeordnet. Dazu gehören beispielsweise Sprachsysteme, wie Amazon’s Alexa oder Apple’s Siri, sowie Fahrassistenten in autonomen Fahrzeugen.

Dem gegenüber steht die sogenannte Broad AI (auch starke AI oder Artificial General Intelligence (AGI)), welche aktuell noch ein theoretisches Phänomen ist. Dieser Begriff bezeichnet Computer, die eine Intelligenz besitzen, welche mit der menschlichen Intelligenz vergleichbar ist. Dies würde bedeuten, dass das Modell verschiedenste Anwendungen eigenständig und gut lösen könnte und gleichzeitig dazulernt.

Warum ist Artificial Intelligence wichtig?

Es gibt viele Bereiche in denen Artificial Intelligence bereits heute eine wichtige Rolle eingenommen hat. Unternehmen sind dadurch beispielsweise in der Lage bessere Entscheidungen zu treffen, ihre Prozesse zu verbessern und die Produkte besser an die Wünsche des Kunden anzupassen. Gleichzeitig erleichtern uns Produkte, die Künstliche Intelligenz nutzen, in vielen Fällen das Leben, beispielsweise in Form von sprachlichen Assistenten, beim Auto fahren oder durch Vorschläge beim Einkaufen.

Im Allgemeinen ist Artificial Intelligence unter anderem aus diesen Gründen wichtig:

- Übernahme von wiederholenden Aufgaben: Durch Künstliche Intelligenz können wiederholende Prozesse, beispielsweise in der Produktion, nicht nur automatisiert, sondern auch stetig verbessert werden. Dem Menschen können diese meist ermüdende Tätigkeiten abgenommen werden und er kann sich anderen Aufgaben widmen.

- Erhöht Nutzen von bestehenden Produkten: Viele Anwendungen und Produkte um uns herum haben bereits ein hohes Qualitätsniveau erreicht. Durch Künstliche Intelligenz können sie jedoch noch weiter verbessert und an die Bedürfnisse angepasst werden. Sprachsysteme können beispielsweise die Bedienbarkeit von Handys, Computern oder auch Websiten erhöhen, indem sie die Suche nach gewissen Funktionalitäten ersparen und Fragen direkt beantworten.

- Nutzung von Zusammenhängen aus Daten: Die Nutzung von Künstlicher Intelligenz und insbesondere Deep Learning eröffnet die Möglichkeit Zusammenhänge in großen Datenmengen zu erkennen und diese anzuwenden. Das können auch Beziehungen sein, die uns Menschen noch gar nicht bewusst waren. Dadurch wird neues Wissen generiert, welches wir nutzen können.

Welche Anwendungen hat Künstliche Intelligenz?

Wir nutzen heute bereits eine Vielzahl von Artificial Intelligence Modellen bewusst und unbewusst. Die folgende Liste ist eine Ausführung der weit-verbreitesten Systeme:

- Spracherkennung: Ob im Auto, am Handy oder mit speziellen Geräten, wie Amazon Alexa, Spracherkennung ist mittlerweile in vielen Geräten verbaut. Als Grundlage dienen alle möglichen Formen von Modellen, die mithilfe von Künstlicher Intelligenz trainiert wurden.

- Computer Vision: Die Fähigkeit, dass Maschinen Objekte erkennen oder Bilder interpretieren können, ist auch Artificial Intelligence zu verdanken. Sie wird aktuell beispielsweise schon dafür genutzt, um medizinische Diagnosen anhand von Röntgenaufnahmen zu machen oder um Personen auf Bildern zu erkennen und zu markieren.

- Recommendation: Egal ob auf Youtube, E-Commerce Portalen oder bei Netflix, diese Anbieter versuchen uns möglichst präzise Empfehlungen zu machen, sodass wir als Kunden entweder länger auf der Plattform bleiben oder mehr Produkte kaufen. Diese Empfehlungen basieren auf verschiedenen KI-Algorithmen und Modellen.

Welche Bereiche gib es in Artificial Intelligence?

Der Begriff Artificial Intelligence ist ein Überbegriff, der alle Bereiche beinhaltet, die zum Ziel haben einer Maschine oder einem Computer menschliches Verhalten beizubringen. Dabei beinhaltet es auch den Bereich des Machine Learnings, der vor allem mithilfe von statistischen Methoden, wie beispielsweise der Principal Component Analysis oder dem Decision Tree, und einem Lernprozess versucht seine Ergebnisse schrittweise zu verbessern.

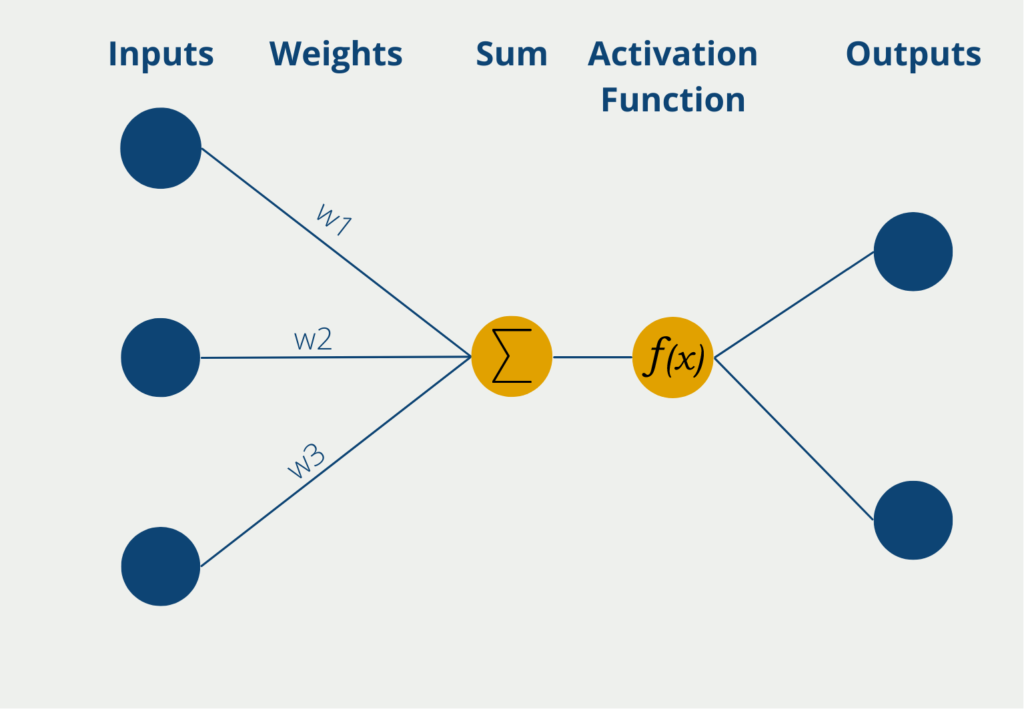

Abschließend gibt es noch das Deep Learning, das wiederum ein Teilgebiet von Machine Learning ist. Es nutzt die Strukturen eines Neuronalen Netzwerks, um seine Ergebnisse zu berechnen. Durch diese vielschichtigen Netzwerke lassen sich auch deutlich komplexere Zusammenhänge erlernen als mit den einfacheren Modellen im Bereich Machine Learning.

Welche ethischen Bedenken gibt es zu Künstlicher Intelligenz?

KI hat das Potenzial, viele Branchen zu verändern und der Gesellschaft erhebliche Vorteile zu bringen. Sie wirft jedoch auch ethische Fragen auf, die geklärt werden müssen, um sicherzustellen, dass KI auf verantwortungsvolle und vertrauenswürdige Weise eingesetzt wird. Einige der wichtigsten ethischen Bedenken im Zusammenhang mit KI sind:

- Bias: Künstliche Intelligenz kann voreingenommen sein, wenn sie auf der Grundlage von Daten trainiert werden, die gesellschaftliche Voreingenommenheit widerspiegeln, z. B. in Bezug auf Rasse oder Geschlecht. Dies kann zu ungerechten oder diskriminierenden Ergebnissen führen, insbesondere in Bereichen wie Einstellung, Kreditvergabe und Strafjustiz. Der Umgang mit Vorurteilen in der KI erfordert sorgfältige Aufmerksamkeit bei der Datenerfassung und der Entwicklung von Algorithmen sowie eine kontinuierliche Überwachung und Prüfung, um sicherzustellen, dass KI-Systeme fair und unvoreingenommen sind.

- Datenschutz: KI-Systeme benötigen oft Zugang zu großen Datenmengen, was Bedenken hinsichtlich des Datenschutzes aufwirft. Personenbezogene Daten können missbraucht oder gestohlen werden, und es besteht die Gefahr, dass KI-Systeme zur Überwachung oder für andere Zwecke eingesetzt werden, die die Privatsphäre des Einzelnen verletzen. Um diese Bedenken auszuräumen, sollten KI-Systeme unter Berücksichtigung des Datenschutzes entwickelt werden, und es sollten geeignete Schutzmaßnahmen zum Schutz personenbezogener Daten getroffen werden.

- Verdrängung von Arbeitsplätzen: Da KI-Systeme immer besser in der Lage sind, Aufgaben zu übernehmen, die früher von Menschen erledigt wurden, besteht die Gefahr, dass sie zur Verdrängung von Arbeitsplätzen führen. Dies könnte insbesondere Arbeitnehmer in Branchen wie der verarbeitenden Industrie und dem Transportwesen betreffen. Um diesem Problem zu begegnen, muss man sich auf die Umschulung von Arbeitnehmern konzentrieren und ihnen die für die Arbeitsplätze der Zukunft erforderlichen Fähigkeiten vermitteln.

- Transparenz und Rechenschaftspflicht: KI-Systeme können undurchsichtig und schwer zu verstehen sein, was Bedenken hinsichtlich der Rechenschaftspflicht und Transparenz aufwirft. Es kann schwierig sein, festzustellen, wie Entscheidungen von KI-Systemen getroffen werden, insbesondere in Fällen, in denen sie erhebliche Auswirkungen auf das Leben der Menschen haben. Um hier Abhilfe zu schaffen, muss der Schwerpunkt auf die Entwicklung von KI-Systemen gelegt werden, die erklärbar und transparent sind und die überprüft und getestet werden können, um sicherzustellen, dass sie wie beabsichtigt funktionieren.

Insgesamt ist die Auseinandersetzung mit diesen ethischen Bedenken von entscheidender Bedeutung, um sicherzustellen, dass KI in einer verantwortungsvollen und vertrauenswürdigen Weise eingesetzt wird, die der Gesellschaft insgesamt zugute kommt. Indem wir einen durchdachten und proaktiven Ansatz verfolgen, können wir dazu beitragen, dass KI auf eine faire, transparente und für alle vorteilhafte Weise eingesetzt wird.

Was ist der Unterschied zwischen Deep Learning und Machine Learning?

Deep Learning ist ein Teilbereich von Machine Learning, der sich von Machine Learning darin unterscheidet, dass kein Mensch in den Lernprozess involviert ist. Dies basiert auf der Tatsache, dass Deep Learning Algorithmen in der Lage sind unstrukturierte Daten, wie Bilder, Videos oder Audiodateien zu verarbeiten. Andere Machine Learning Modelle hingegen benötigen für die Verarbeitung dieser Daten die Hilfe von Menschen, die ihnen beispielsweise mitteilen, dass in dem Bild ein Auto zu erkennen ist. Deep Learning Algorithmen hingegen können unstrukturierte Daten automatisiert in numerische Werte umwandeln und diese dann in ihre Vorhersagen mit einbeziehen und Strukturen erkennen, ohne dass eine menschliche Interaktion stattgefunden hat.

Darüber hinaus sind Deep Learning Algorithmen in der Lage deutlich größere Datenmengen zu verarbeiten und somit auch komplexere Aufgaben anzugehen, als herkömmliche Machine Learning Modelle. Jedoch geht dies zu Lasten einer deutlich längeren Trainingszeit von Deep Learning Modellen. Gleichzeitig sind diese Modelle auch nur sehr schwierig interpretierbar. Das heißt, wir können nicht verstehen, wie ein Neuronales Netzwerk zu einer guten Vorhersage kam.

Das solltest Du mitnehmen

- Künstliche Intelligenz bezeichnet den Versuch Computern menschliches Denken beizubringen.

- Es wird zwischen schwacher und starker AI unterschieden. Erstere bezeichnet Modelle, die in einzelnen Anwendungsfällen sehr gute Ergebnisse liefert. Eine starke AI hingegen ist mit menschlicher Intelligenz vergleichbar.

- Künstliche Intelligenz begegnet uns heutzutage schon in verschiedenen Anwendungen, wie beispielsweise bei Recommendation Systemen, bei der Spracherkennung oder bei Computer Vision.

Was ist die Lasso Regression?

Entdecken Sie die Lasso Regression: ein leistungsstarkes Tool für die Vorhersagemodellierung und die Auswahl von Merkmalen.

Was ist der Omitted Variable Bias?

Verständnis des Omitted Variable Bias: Ursachen, Konsequenzen und Prävention. Erfahren Sie, wie Sie diese Falle vermeiden.

Was ist der Adam Optimizer?

Entdecken Sie den Adam Optimizer: Lernen Sie den Algorithmus kennen und erfahren Sie, wie Sie ihn in Python implementieren.

Was ist One-Shot Learning?

Beherrsche One-Shot Learning: Techniken zum schnellen Wissenserwerb und Anpassung. Steigere die KI-Leistung mit minimalen Trainingsdaten.

Was ist die Bellman Gleichung?

Die Beherrschung der Bellman-Gleichung: Optimale Entscheidungsfindung in der KI. Lernen Sie ihre Anwendungen und Grenzen kennen.

Was ist die Singular Value Decomposition?

Erkenntnisse und Muster freilegen: Lernen Sie die Leistungsfähigkeit der Singular Value Decomposition (SVD) in der Datenanalyse kennen.

Andere Beiträge zum Thema Künstliche Intelligenz

Folgende Websites lieferen weiterführende Artikel zu diesem Thema und dienten als Quellen:

Niklas Lang

Seit 2020 bin ich als Machine Learning Engineer und Softwareentwickler tätig und beschäftige mich leidenschaftlich mit der Welt der Daten, Algorithmen und Softwareentwicklung. Neben meiner Arbeit in der Praxis unterrichte ich an mehreren deutschen Hochschulen, darunter die IU International University of Applied Sciences und die Duale Hochschule Baden-Württemberg, in den Bereichen Data Science, Mathematik und Business Analytics.

Mein Ziel ist es, komplexe Themen wie Statistik und maschinelles Lernen so aufzubereiten, dass sie nicht nur verständlich, sondern auch spannend und greifbar werden. Dabei kombiniere ich praktische Erfahrungen aus der Industrie mit fundierten theoretischen Grundlagen, um meine Studierenden bestmöglich auf die Herausforderungen der Datenwelt vorzubereiten.