XGBoost steht für Extreme Gradient Boosting und ist eine Open-Source Machine Learning Bibliothek. Sie bietet gängige Machine Learning Algorithmen, welche den sogenannten Boosting Algorithmus nutzen. Die Bibliothek geht dabei äußerst effizient mit dem Speicher und der Rechenleistung um und liefert dadurch eine hohe Performance beim Trainieren der Modelle.

Was ist Boosting?

Im Machine Learning kommen nicht immer nur einzelne Modelle zum Einsatz. Um die Leistung des gesamten Programms zu verbessern, werden teilweise auch mehrere einzelne Modelle zu einem sogenannten Ensemble zusammengefasst. Ein Random Forest beispielsweise besteht aus vielen, einzelnen Decision Trees, deren Ergebnisse dann zu einem Resultat vereint werden.

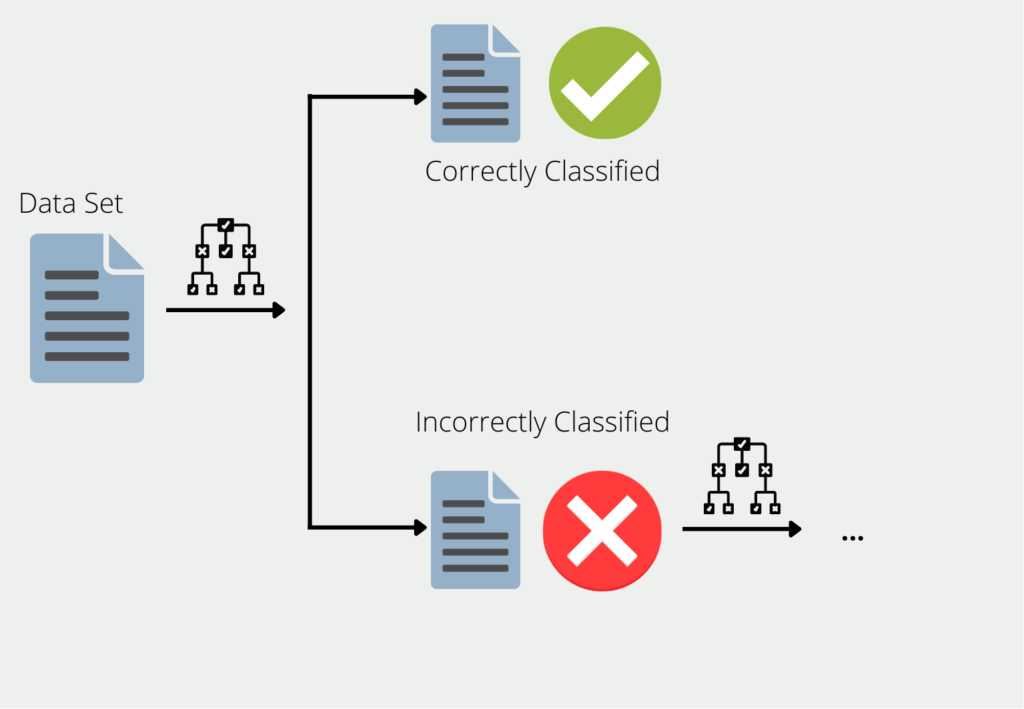

Das Boosting beschreibt die Vorgehensweise wie mehrere Modelle zu einem Ensemble zusammengefasst werden. Am Beispiel von Decision Trees, werden die Trainingsdaten genutzt, um einen Baum zu trainieren. Für alle die Daten, für die der erste Decision Tree schlechte oder falsche Ergebnisse liefert, wird ein zweiter Decision Tree gebildet. Dieser wird dann ausschließlich mit den Daten trainiert, die der erste falsch klassifiziert hat. Diese Kette wird weitergeführt und der nächste Baum wiederum nutzt die Informationen, die bei den ersten beiden Bäumen zu schlechten Ergebnissen geführt haben.

Das Ensemble aus all diesen Decision Trees kann dann für den gesamten Datensatz gute Ergebnisse liefern, da jedes einzelne Modell die Schwächen der anderen kompensiert. Man spricht auch davon, dass viele “schwache Lerner” (english: weak learners) zu einem “starken Lerner” (english: “strong learner”) zusammengefasst werden.

Was ist Gradient Boosting?

Das Gradient Boosting wiederum ist eine Untergruppe von vielen, verschiedenen Boosting Algorithmen. Die Grundidee dahinter ist, dass das nächste Modell so gebaut werden sollte, dass es die Verlustfunktion des Ensembles weiter minimiert.

In den einfachsten Fällen beschreibt die Verlustfunktion einfach die Differenz zwischen der Vorhersage des Modells und dem tatsächlichen Wert. Angenommen wir trainieren eine KI zur Vorhersage eines Hauspreises. Die Verlustfunktion könnte dann einfach der Mean Squared Error zwischen dem tatsächlichen Preis des Hauses und dem vorhergesagten Preis des Hauses sein. Im Idealfall nähert sich die Funktion im Lauf der Zeit null an und unser Modell kann korrekte Preise vorhersagen.

Es werden solange neue Modelle hinzugefügt, wie sich Vorhersage und Realität nicht mehr unterscheiden, also die Verlustfunktion das Minimum erreicht hat. Jedes neue Modell versucht dabei den Fehler des vorherigen Modells vorherzusagen.

Kommen wir zurück zu unserem Beispiel mit den Hauspreisen. Angenommen ein Objekt hat eine Wohnfläche von 100m², vier Zimmer, eine Garage und kostet 200.000€. Der Ablauf des Gradient Boostings würde dann wie folgt aussehen:

- Training einer Regression zur Vorhersage des Kaufpreises mit den Features Wohnfläche, Anzahl Zimmer und Garage. Dieses Modell sagt einen Kaufpreis von 170.000 € vorher anstatt den tatsächlichen 200.000 €, der Fehler beträgt also 30.000 €.

- Training einer weiteren Regression die den Fehler des vorherigen Modells vorhersagt mit den Features Wohnfläche, Anzahl Zimmer und Garage. Dieses Modell sagt eine Abweichung von 23.000 € voraus anstatt den tatsächlichen 30.000 €. Der verbleibende Fehler beträgt also 7.000 €.

Diese Schritte werden so lange wiederholt, bis der verbleibende Fehler möglichst klein oder sogar Null ist.

Was sind die Vor- und Nachteile von Boosting im Allgemeinen?

Der allgemeine Vorteil von Boosting ist, dass viele schwache Lerner zu einem starken und leistungsfähigen Modell kombiniert werden. Trotz der großen Anzahl der kleinen Modelle sind diese Boosting Algorithmen meist einfacher zu berechnen als vergleichbare Neuronale Netzwerke. Das muss jedoch nicht bedeuten, dass sie auch schlechtere Ergebnisse liefern. Teilweise können Ensemble Modelle die komplexeren Netzwerke sogar im Hinblick auf die Genauigkeit schlagen. Somit sind sie auch interessante Kandidaten für Text- oder Bildklassifikationen.

Darüber hinaus neigen Boosting Algorithmen, wie beispielsweise auch AdaBoost, auch weniger zu Overfitting. Dies bedeutet einfach gesagt, dass sie nicht nur mit dem Trainingsdatensatz gute Ergebnisse liefern, sondern auch mit neue Daten mit einer hohen Genauigkeit gut klassifizieren. Man geht davon aus, dass die mehrstufige Modellberechnung von Boosting Algorithmen nicht so anfällig für Abhängigkeiten, wie die Schichten in einem Neuronalen Netzwerk, da die Modelle nicht zusammenhängend optimiert werden, wie dies bei der Backpropagation im Modell der Fall ist.

Durch das schrittweise Trainieren von Einzelmodellen haben Boosting Modelle oft eine relativ langsame Lernrate und benötigen dadurch mehr Iterationen um gute Ergebnisse zu liefern. des Weiteren benötigen sie sehr gute Datensätze, da die Modelle sehr sensibel auf Noise reagieren und dieses somit im Data Preprocessing entfernt werden sollte.

Welche Vorteile bietet die Nutzung von XGBoost?

Die XGBoost Bibliothek bietet die Möglichkeit große Datensätze mit bewährten Machine Learning Algorithmen zu trainieren und dabei die Rechenleistung zu optimieren. Darüber hinaus bietet XGBoost diese Vorteile:

- Open-Source Plattform für verschiedene Programmiersprachen, wie Python oder R.

- Eine große Zahl an Nutzern und Entwicklern, die die Plattform durchgehend weiterentwickeln.

- Algorithmen für eine Vielzahl an Anwendungsfällen, wie beispielsweise Klassifizierung oder Regression.

- Flexibles und performantes Training von Machine Learning Modellen, das zusätzlich auch in die Cloud verlagert werden kann.

Was sind die Herausforderungen von Gradient Boosting?

Das Gradient Boosting ist eine beliebte Wahl für verschiedenste Anwendungen, da es sich auf verschiedenste Szenarien anpassen lässt. Trotz dieser zahlreichen Vorteile gibt es jedoch auch einige Nachteile oder Einschränkungen, die bei der Nutzung beachtet werden sollten:

- Overfitting: Das Gradient Boosting neigt zu Overfitting, wenn die Hyperparameter nicht optimal eingestellt sind bzw. die Modellkomplexität zu hoch ist. Dadurch wird die Generalisierungsleistung beeinträchtigt, sodass das Modell keine guten Vorhersagen für neue Daten liefert.

- Zeit- und Ressourcenverbrauch: Ein weiteres Problem bei Boosting Methoden allgemein ist die verlängerte Trainingszeit, da mehr Modelle trainiert werden, die Rechenressourcen in Anspruch nehmen. Deshalb sollte bei Gradient Boosting darauf geachtet werden, dass die maximale Tiefe der Bäume und die Anzahl der Blätter definiert wird, um den Rechenaufwand zu begrenzen.

- Begrenzte Interpretierbarkeit: Durch die Kombination der verschiedenen Modelle lässt sich eine einzelne Vorhersage nur sehr schwierig interpretieren. Dadurch wird das Modell zu einer Black-Box, sodass sich die Rückschlüsse nicht direkt nachvollziehen lassen. Wenn für die Anwendung ein transparentes Modell mit einer guten Interpretierbarkeit benötigt wird, sollte besser auf einen einzelnen Decision Tree zurückgegriffen werden.

- Vorverarbeitung der Daten: Die Modellleistung bei einem Gradient Boosting Modell ist auch maßgeblich von der Vorverarbeitung der Daten abhängig. Dazu zählt beispielsweise, dass kategorische Variablen kodiert werden oder die Merkmale skaliert sind. Wenn dies nicht der Fall ist, kann es erhebliche, negative Auswirkungen auf die Modellleistung haben. Außerdem führen Ausreißer oft zu schlechteren Ergebnissen und sollten deshalb aus dem Datensatz entfernt werden.

- Unausgewogene Daten: Für Klassifizierungsaufgaben ist die Ausgeglichenheit des Datensatzes immens wichtig, um ein aussagekräftiges Gradient Boosting Modell zu trainieren. Ansonsten kann es zu erheblich verzerrten Modellen kommen.

Abschließend ist das Gradient Boosting eine leistungsstarke Methode, die viele Vorteile mit sich bringt. Wenn die in diesem Abschnitt genannten Punkte beim Training berücksichtigt werden, steht einem leistungsstarken Modell nichts im Wege.

Welche Anwendungen können mit XGBoost gelöst werden?

Die XGBoost Bibliothek wurde entwickelt, um eine hohe Rechenleistung beim Training bereitzustellen und das Training zu parallelisieren und zu beschleunigen. Dafür sorgt das bereits erklärte Gradient Boosting, welches viele, sogenannte schwache Lerner zu einem leistungsstarken Modell zusammenfasst.

Es handelt sich dabei um mehrere Decision Trees, die nicht wie bei einem Random Forest zu einem Ensemble zusammengeführt werden, sondern nach dem Gradient Boosting Algorithmus miteinander kombiniert werden, um eine optimale Performance zu gewährleisten. Dementsprechend können auch diesselben Anwendungsfelder umgesetzt werden, wie bei herkömmlichen Entscheidungsbäumen.

Die Entscheidungsbäume werden abhängig von der Zielvariablen für Klassifizierungen oder Regressionen genutzt. Wenn der letzte Wert des Baums auf einer kontinuierlichen Skala abbildbar ist, spricht man von einem Regressionsbaum. Wenn die Zielvariable hingegen einer Kategorie angehört, sprechen wir von einem Klassifizierungsbaum.

Durch die einfache Struktur ist diese Art der Entscheidungsfindung sehr beliebt und wird in verschiedensten Bereichen eingesetzt:

- Betriebswirtschaft: Undurchsichtige Kostenstrukturen können mithilfe einer Baumstruktur veranschaulicht werden und machen deutlich, welche Entscheidungen wie viele Kosten nach sich ziehen.

- Medizin: Für Patienten sind Entscheidungsbäume eine Hilfe, um herauszufinden, ob sie ärztliche Hilfe aufsuchen sollten.

- Machine Learning und Künstliche Intelligenz: In diesem Bereich werden Decision Trees verwendet, um Klassifizierungs- oder Regressionsaufgaben zu erlernen und dann Vorhersagen zu treffen.

Welchen Boosting Algorithmus soll man wählen?

Im Bereich des Machine Learnings stehen verschiedene Boosting Algorithmen zur Verfügung, die alle Vor- und Nachteile haben. Die Wahl des richtigen Modellsl kann deshalb schnell schwieirig werden und hängt von unterschiedlichen Faktoren, wie beipsielsweise der Größe des Datensatzes und dem Grad der Interpretierbarkeit ab.

In diesem Abschnitt geben wir einen kurzen Überblick über die drei wichtigsten Boosting-Algorithmen und wann diese gewählt werden sollten:

- AdaBoost (Adaptive Boosting) ist eine beliebte Wahl für Klassifizierungsaufgaben. Dabei werden mehrere schwache Klassifikatoren kombiniert und in mehreren Iterationen trainiert. Die Durchläufe unterscheiden sich dadurch, dass die Trainingsproben Gewichtungen erhalten und damit ein neuer Klassifikator trainiert wird. Dadurch wird es dem Boosting Algorithmus ermöglicht, sich mehr auf die falsch klassifizierten Trainingsbeispiele zu konzentrieren. Deshalb eignet sich AdaBoost für Klassifizierungsaufgaben mit mittelgroßen Datensätzen.

- XGBoost (Extreme Gradient Boosting) nutzt Decision Trees als Basis und beruht außerdem auf der Regularisierung, um eine Überanpassung zu verhindern. Dadurch können auch große Datensätze mit hochdimensionalen Merkmalen verarbeitet werden. Außerdem lassen sich sowohl Regressions- als auch Klassifikationsaufgaben besonders leistungsfähig verwirklichen. Dadurch ist XGBoost ein sehr breit aufgestelltes Modell, das für viele Anwendungen genutzt werden kann.

- Gradient Boosting ist ein sehr allgemeiner Ansatz, der mit verschiedenen Verlustfunktionen und zugrundeliegenden Modellen individualisiert werden kann. Dabei wird durch die Kombination verschiedener schwacher Lerner ein starker Lerner gebildet, der die Verlustfunktion so weit wie möglich minimiert. Durch diesen flexiblen Aufbau können verschiedenen Datentypen, insbesondere auch kategorische Merkmale, abgebildet werden.

Somit wird AdaBoost vor allem für einfache Klassifizierungsaufgaben mit kleinen bis mittelgroßen Datensätzen genutzt. Für große Datensätze mit hochdimensionalen Merkmalen hingegen ist XGBoost eine gute Wahl, da durch die Regulaisierung Overfitting effektiv verhindert wird. Das Gradient Boosting hingegen ist gewissermaßen die Mitte zwischen diesen beiden Ansätzen und kann durch die Individualisierbarkeit für verschiedenste Anwendungen genutzt werden.

Das solltest Du mitnehmen

- XGBoost steht für Extreme Gradient Boosting und ist eine Open-Source Machine Learning Bibliothek.

- Sie bietet gängige Machine Learning Algorithmen, welche den sogenannten Boosting Algorithmus nutzen. Dieser wird genutzt um mehrere Decision Trees zu einem performanten Ensemble Modell zusammenzufügen.

- Die Vorteile von XGBoost sind die effiziente Nutzung von Rechenleistung und die guten Ergebnisse, welche die Modelle in vielen Anwendungsfällen liefern.

- Nichtsdestotrotz konnten Neuronale Netzwerke bereits in vielen Vergleichsexperimenten die bereits guten Ergebnisse von XGBoost Modellen schlagen.

Was ist die Random Search?

Optimieren Sie Modelle für maschinelles Lernen: Lernen Sie, wie die Random Search Hyperparameter effektiv abstimmt.

Was ist die Lasso Regression?

Entdecken Sie die Lasso Regression: ein leistungsstarkes Tool für die Vorhersagemodellierung und die Auswahl von Merkmalen.

Was ist der Omitted Variable Bias?

Verständnis des Omitted Variable Bias: Ursachen, Konsequenzen und Prävention. Erfahren Sie, wie Sie diese Falle vermeiden.

Was ist der Adam Optimizer?

Entdecken Sie den Adam Optimizer: Lernen Sie den Algorithmus kennen und erfahren Sie, wie Sie ihn in Python implementieren.

Was ist One-Shot Learning?

Beherrsche One-Shot Learning: Techniken zum schnellen Wissenserwerb und Anpassung. Steigere die KI-Leistung mit minimalen Trainingsdaten.

Was ist die Bellman Gleichung?

Die Beherrschung der Bellman-Gleichung: Optimale Entscheidungsfindung in der KI. Lernen Sie ihre Anwendungen und Grenzen kennen.

Andere Beiträge zum Thema XGBoost

Niklas Lang

Seit 2020 bin ich als Machine Learning Engineer und Softwareentwickler tätig und beschäftige mich leidenschaftlich mit der Welt der Daten, Algorithmen und Softwareentwicklung. Neben meiner Arbeit in der Praxis unterrichte ich an mehreren deutschen Hochschulen, darunter die IU International University of Applied Sciences und die Duale Hochschule Baden-Württemberg, in den Bereichen Data Science, Mathematik und Business Analytics.

Mein Ziel ist es, komplexe Themen wie Statistik und maschinelles Lernen so aufzubereiten, dass sie nicht nur verständlich, sondern auch spannend und greifbar werden. Dabei kombiniere ich praktische Erfahrungen aus der Industrie mit fundierten theoretischen Grundlagen, um meine Studierenden bestmöglich auf die Herausforderungen der Datenwelt vorzubereiten.