Der Data Lake speichert eine Großzahl von Daten in deren Rohformat, also unverarbeitet, aus unterschiedlichen Quellen ab, um sie für Big Data Analysen nutzbar zu machen. Diese Daten können sowohl strukturiert, semi-strukturiert oder auch unstrukturiert sein. Die Informationen werden dort abgelegt, bis sie für eine analytische Auswertung gebraucht werden.

Warum nutzen Unternehmen einen Data Lake?

Die Daten, die in einem Data Lake abgespeichert werden, können entweder strukturiert, semi-strukturiert oder unstrukturiert sein. Solche Datenformate sind für Relationale Datenbanken, der Grundlage vieler Data Warehouses, ungeeignet.

Zusätzlich sind Relationale Datenbanken auch nicht horizontal skalierbar, wodurch die Datenhaltung in einem Data Warehouse ab einem gewissen Grad sehr teuer werden kann. Horizontale Skalierbarkeit bedeutet, dass das System auf mehrere unterschiedliche Computer aufgeteilt werden kann und somit die Last nicht auf einem einzelnen Rechner liegt. Dies bietet den Vorteil, dass in Stresssituationen, bspw. bei vielen gleichzeitigen Abfragen, einfach bedarfsgesteuert neue Systeme zeitweise hinzugeschaltet werden können.

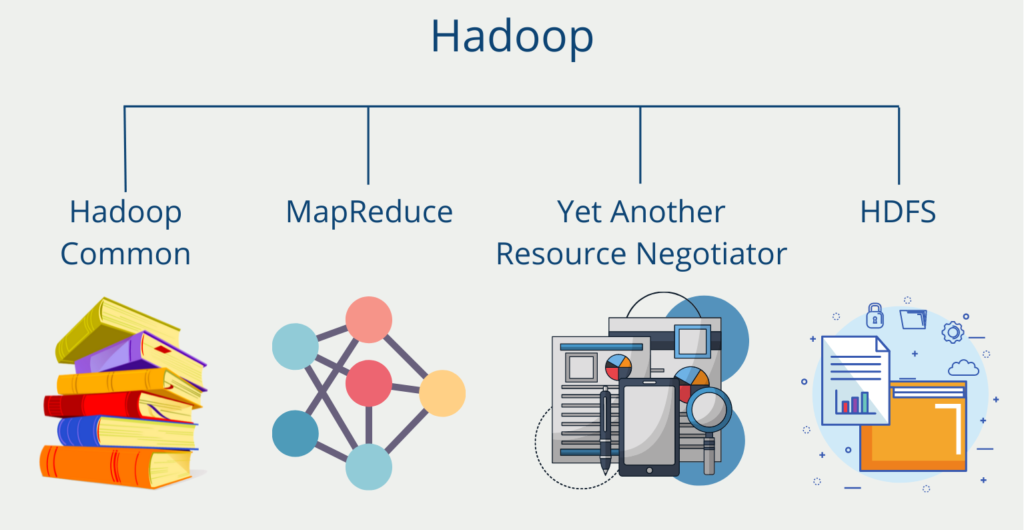

Relationale Datenbanken können per Definition den Datenbestand nicht auf viele Rechner aufteilen, da ansonsten die Datenkonsistenz verloren gehen würde. Aus diesem Grund ist es sehr teuer große Datenmengen in einem Data Warehouse zu speichern. Die meisten Systeme, die für den Data Lake genutzt werden, wie beispielsweise NoSQL Datenbanken oder Hadoop, sind horizontal skalierbar und können dadurch einfacher skaliert werden. Das sind die Hauptgründe weshalb der Data Lake neben dem Data Warehouse zu den Grundpfeilern der Datenarchitektur von vielen Unternehmen gehört.

Wie ist die Architektur aufgebaut?

Die genaue Umsetzung eines Data Lakes ist von Unternehmen zu Unternehmen unterschiedlich. Es gibt jedoch einige grundsätzliche Prinzipien, die für die Datenarchitektur des Data Lakes gelten sollte:

- Alle Daten können aufgenommen werden. Es können grundsätzlich alle Informationen aus Quellsystemen in den Data Lake geladen werden.

- Die Daten müssen nicht erst verarbeitet werden, sondern können in der Ursprungsform geladen und gespeichert werden.

- Die Daten werden erst dann verarbeitet und aufbereitet, wenn es einen speziellen Anwendungsfall mit Voraussetzungen an die Daten gibt. Dieses Vorgehen nennt man auch schema-on-read.

Ansonsten sollten bei der Speicherung unabhängig vom System noch einige grundlegenden Punkte beachtet werden:

- Gemeinsame Ordnerstruktur mit einheitlichen Namenskonventionen, damit Daten schnell und einfach gefunden werden können.

- Erstellung eines Datenkatalogs, der die Herkunft der Dateien benennt und die einzelnen Daten kurz erklärt.

- Tools zum Datenscreening, damit schnell erkennbar ist, wie gut die Datenqualität ist und ob es beispielsweise fehlende Werte gibt.

- Ein standardisierter Datenzugriff, sodass Berechtigungen vergeben werden können und klar ist, wer Zugriff auf die Daten hat.

Wie kann Data Governance sichergestellt werden?

Data Governance ist ein entscheidender Aspekt eines jeden Datenverwaltungssystems, einschließlich Data Lakes. Sie umfasst die Verwaltung der Verfügbarkeit, Nutzbarkeit, Integrität und Sicherheit der in einer Organisation verwendeten Daten. In einem Data Lake stellt Data Governance sicher, dass die Daten von hoher Qualität sind und für diejenigen, die sie benötigen, zugänglich und nutzbar sind.

Im Folgenden sind einige wichtige Faktoren aufgeführt, die bei der Implementierung von Data Governance in diesem Datenspeicher zu berücksichtigen sind:

- Datenklassifizierung: Die Klassifizierung von Daten ist ein wesentlicher Aspekt der Data Governance. Sie hilft dabei, die Sensibilität der Daten zu ermitteln und ihnen Richtlinien für die Datenverarbeitung zuzuweisen. Es geht darum, die verschiedenen Datentypen zu verstehen, z. B. persönliche Daten, vertrauliche Daten oder öffentliche Daten, und sie dann entsprechend zu klassifizieren.

- Datenqualität: Die Datenqualität stellt sicher, dass die Daten korrekt, vollständig und für die Bedürfnisse des Unternehmens relevant sind. In einem Data Lake ist es unerlässlich, Regeln für die Datenqualität aufzustellen und Verfahren zur Datenbereinigung und -validierung zu implementieren, um die Datenqualität zu erhalten.

- Datenzugriff: Die Zugriffskontrolle stellt sicher, dass nur befugtes Personal auf die Daten zugreifen kann. Dazu müssen Zugriffsrichtlinien und -verfahren festgelegt werden, um sicherzustellen, dass nur autorisierte Benutzer auf die Daten zugreifen können.

- Datensicherheit: Die Datensicherheit gewährleistet, dass die Daten vor unberechtigtem Zugriff, Verlust oder Beschädigung geschützt sind. Sie umfasst die Implementierung von Sicherheitsmaßnahmen wie Verschlüsselung, Zugriffskontrolle und Datenmaskierung, um die Datensicherheit zu gewährleisten.

- Datenschutz: Der Datenschutz gewährleistet, dass Daten vor unbefugter Offenlegung geschützt sind. Er umfasst die Implementierung von Datenschutzrichtlinien und -verfahren, um sicherzustellen, dass sensible Daten nicht an unbefugte Personen weitergegeben werden.

Zusammenfassend lässt sich sagen, dass Data Governance in einem Data Lake entscheidend ist, um sicherzustellen, dass die Daten von hoher Qualität, zugänglich und sicher sind. Durch die Implementierung von Data-Governance-Richtlinien und -Verfahren können Unternehmen sicherstellen, dass ihr Data Lake für ihre spezifischen Geschäftsanforderungen optimiert ist.

Was sind die Unterschiede zum Data Warehouse?

Das Data Warehouse kann zusätzlich durch einen Data Lake ergänzt werden, in welchem unstrukturierte Rohdaten kostengünstig zwischengespeichert werden können, um sie zu einem späteren Zeitpunkt nutzen zu können. Die beiden Konzepte unterscheiden sich vor allem in den Daten, die sie speichern, und der Art und Weise, wie die Informationen abgelegt werden.

| Merkmale | Data Warehouse | Data Lake |

|---|---|---|

| Daten | Relationale Daten aus produktiven Systemen oder anderen Datenbanken. | Alle Datentypen (strukturiert, semi-strukturiert, unstrukturiert). |

| Datenschema | Können entweder vor der Erstellung des Data Warehouses geplant werden oder erst während der Analyse (Schema-on-Write oder Schema-on-Read) | Ausschließlich zum Analysezeitpunkt (Schema-on-Read) |

| Abfrage | Mit lokalem Speicher sehr schnelle Abfrageergebnisse | – Entkopplung von Berechnungen und Speicher – Schnelle Abfrageergebnisse mit günstigem Speicher |

| Datenqualität | – Vorverarbeitete Daten aus verschiedenen Quellen – Vereinheitlichung – Single Point of Truth | – Rohdaten – Bearbeitet und unbearbeitet |

| Anwendungen | Business Intelligence und grafische Aufbereitung der Daten | Künstliche Intelligenz, Analysen, Business Intelligence, Big Data |

Data Lakehouse vs. Data Lake

Data Lakehouses und Data Lakes haben zwar einige Gemeinsamkeiten, unterscheiden sich aber grundlegend in ihrem Ansatz für die Datenverwaltung. Ein Data Lake ist ein zentrales Repository, in dem strukturierte, halbstrukturierte und unstrukturierte Daten in ihrer Rohform gespeichert werden. Die Daten werden nicht verarbeitet oder umgewandelt, und es gibt kein definiertes Schema oder eine Struktur. Dieser Ansatz bietet Unternehmen die Flexibilität, Daten aus verschiedenen Quellen und Formaten zu speichern, aber es kann schwierig sein, die Daten zu analysieren und Erkenntnisse daraus abzuleiten.

Im Gegensatz dazu bieten Data Lakehouses den Unternehmen die Vorteile eines Data Lakes, wie Flexibilität und Skalierbarkeit, und gleichzeitig die Struktur und Organisation eines Data Warehouse. Data Lakehouses speichern Daten in ihrer Rohform, setzen aber auch einen Schema-on-Read-Ansatz durch, der es den Unternehmen erleichtert, ihre Daten zu analysieren und Erkenntnisse daraus abzuleiten.

Das solltest Du mitnehmen

- Der Data Lake bezeichnet einen großen Datenspeicher, der Daten im Rohformat aus den Quellsystemen abspeichert, damit sie für spätere Analysen zur Verfügung stehen.

- Sie können strukturierte, semi-strukturierte und unstrukturierte Daten abspeichern.

- Sie unterscheiden sich grundsätzlich vom Data Warehouse darin, dass sie unverarbeitete Daten abspeichern und die Daten erst aufbereitet werden, wenn ein konkreter Anwendungsfall besteht.

- Es handelt sich dabei vor allem um eine Vorratsdatenhaltung.

Was ist OpenAPI?

Erkunden Sie OpenAPI: Ein Leitfaden zum Aufbau und zur Nutzung von RESTful APIs. Lernen Sie, wie man APIs entwirft und dokumentiert.

Was ist Data Governance?

Sichern Sie die Qualität, Verfügbarkeit und Integrität der Daten Ihres Unternehmens durch effektives Data Governance. Erfahren Sie mehr.

Was ist Datenqualität?

Sicherstellung der Datenqualität: Bedeutung, Herausforderungen und bewährte Praktiken. Erfahren Sie, wie Sie hochwertige Daten erhalten.

Was ist die Datenimputation?

Imputieren Sie fehlende Werte mit Datenimputationstechniken. Optimieren Sie die Datenqualität und erfahren Sie mehr über die Techniken.

Was ist Ausreißererkennung?

Entdecken Sie Anomalien in Daten mit Verfahren zur Ausreißererkennung. Verbessern Sie ihre Entscheidungsfindung!

Was ist die Bivariate Analyse?

Nutzen Sie die Bivariate Analyse: Erforschen Sie Typen und Streudiagramme und nutzen Sie Korrelation und Regression.

Andere Beiträge zum Thema Data Lake

- Amazon AWS bietet eine ausführliche theoretische Erklärung zum Thema Data Lakes und bietet auch die Möglichkeiten diesen in der Cloud aufzubauen.

Niklas Lang

Seit 2020 bin ich als Machine Learning Engineer und Softwareentwickler tätig und beschäftige mich leidenschaftlich mit der Welt der Daten, Algorithmen und Softwareentwicklung. Neben meiner Arbeit in der Praxis unterrichte ich an mehreren deutschen Hochschulen, darunter die IU International University of Applied Sciences und die Duale Hochschule Baden-Württemberg, in den Bereichen Data Science, Mathematik und Business Analytics.

Mein Ziel ist es, komplexe Themen wie Statistik und maschinelles Lernen so aufzubereiten, dass sie nicht nur verständlich, sondern auch spannend und greifbar werden. Dabei kombiniere ich praktische Erfahrungen aus der Industrie mit fundierten theoretischen Grundlagen, um meine Studierenden bestmöglich auf die Herausforderungen der Datenwelt vorzubereiten.