Natural Language Processing ist ein Teilbereich von Computer Science, der sich damit beschäftigt natürliche Sprache, also beispielsweise Texte oder Sprachaufnahmen, verstehen und verarbeiten zu können. Das Ziel ist es, dass eine Maschine in der gleichen Weise mit Menschen kommunizieren kann, wie es Menschen untereinander bereits seit Jahrhunderten tun.

Was sind die Bereiche von NLP?

Eine neue Sprache zu erlernen ist auch für uns Menschen nicht einfach und erfordert viel Zeit und Durchhaltevermögen. Wenn eine Maschine natürliche Sprache erlernen will, ist es nicht anders. Deshalb haben sich einige Teilbereiche innerhalb des Natural Language Processings herausgebildet, die notwendig sind, damit Sprache komplett verstanden werden kann.

Diese Unterteilungen können auch unabhängig voneinander genutzt werden, um einzelne Aufgaben zu lösen:

- Speech Recognition versucht aufgezeichnete Sprache zu verstehen und in textuelle Informationen umzuwandeln. Das macht es für nachgeschaltete Algorithmen einfacher die Sprache zu verarbeiten. Speech Recognition kann jedoch auch alleinstehend genutzt werden, beispielsweise um Diktate oder Vorlesungen in Text zu verwandeln.

- Part of Speech Tagging wird genutzt um die grammatikalische Zusammensetzung eines Satzes zu erkennen und die einzelnen Satzbestandteile zu markieren.

- Named Entity Recognition versucht innerhalb eines Textes Wörter und Satzbausteine zu finden, die einer vordefinierten Klasse zugeordnet werden können. So können dann zum Beispiel alle Phrasen in einem Textabschnitt markiert werden, die einen Personennamen enthalten oder eine Zeit ausdrücken.

- Sentiment Analysis klassifiziert das Sentiment, also die Gefühlslage, eines Textes in verschiedene Stufen. Dadurch kann beispielsweise automatisiert erkannt werden, ob eine Produktbewertung eher positiv oder eher negativ ist.

- Natural Language Generation ist eine allgemeine Gruppe von Anwendungen mithilfe derer automatisiert neue Texte generiert werden sollen, die möglichst natürlich klingen. Zum Beispiel können mithilfe von kurzen Produkttexten ganze Marketingbeschreibungen dieses Produkts erstellt werden.

Welche Algorithmen nutzt man für NLP?

Die meisten, grundlegenden Anwendungen von NLP können mit den Python Modulen spaCy und NLTK umgesetzt werden. Diese Bibliotheken bieten weitreichende Modelle zur direkten Anwendung auf einen Text, ohne vorheriges Trainieren eines eigenen Algorithmus. Mit diesen Modulen ist ohne weiteres ein Part of Speech Tagging oder Named Entity Recognition in verschiedenen Sprachen möglich.

Der Hauptunterschied zwischen diesen beiden Bibliotheken ist die Ausrichtung. NLTK ist vor allem für Entwickler gedacht, die eine funktionierende Applikation mit Natural Language Processing Modulen erstellen wollen und dabei auf Performance und Interkompatibilität angewiesen sind. SpaCy hingegen versucht immer Funktionen bereitzustellen, die auf dem neuesten Stand der Literatur sind und macht dabei möglicherweise Einbußen bei der Performance.

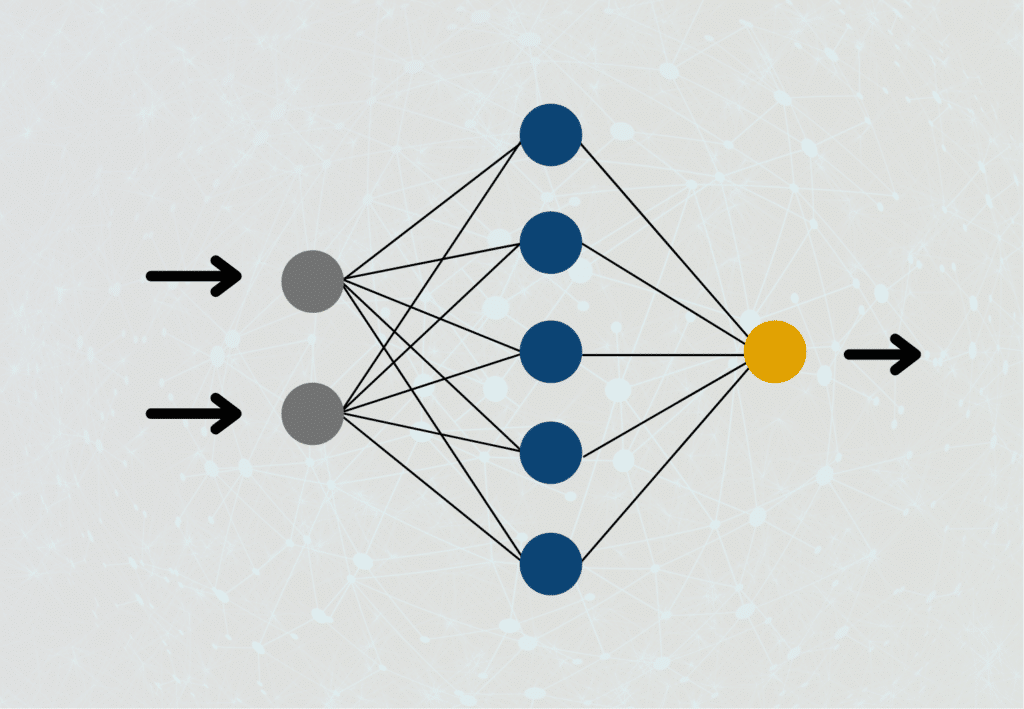

Für umfangreichere und komplexere Anwendungen reichen jedoch diese Optionen nicht mehr aus, beispielsweise wenn man eine eigene Sentiment Analyse erstellen will. Je nach Anwendungsfall sind dafür noch allgemeine Machine Learning Modelle ausreichend, wie beispielsweise ein Convolutional Neural Network (CNN). Mithilfe von Tokenizern von spaCy oder NLTK können die einzelnen in Wörter in Zahlen umgewandelt werden, mit denen wiederum das CNN als Input arbeiten kann. Auf heutigen Computern sind solche Modelle mit kleinen Neuronalen Netzwerken noch relativ schnell trainierbar und deren Einsatz sollte deshalb immer erst geprüft und möglicherweise auch getestet werden.

Jedoch gibt es auch Fälle in denen sogenannte Transformer Modelle benötigt werden, die im Bereich des Natural Language Processing aktuell state-of-the-art sind. Sie können inhaltliche Zusammenhänge in Texten besonders gut mit in die Aufgabe einbeziehen und liefern daher bessere Ergebnisse beispielsweise bei der Machine Translation oder bei Natural Language Generation. Jedoch sind diese Modelle sehr rechenintensiv und bedeuten eine sehr lange Rechenzeit auf normalen Computern.

Was sind die Unterschiede zwsichen NLU und NLP?

Die Begriffe Natural Language Understanding und Natural Language Processing werden fälschlicherweise oft durcheinander gebracht. Natural Language Processing ist ein Teilbereich von Computer Science, der sich damit beschäftigt natürliche Sprache, also beispielsweise Texte oder Sprachaufnahmen, verstehen und verarbeiten zu können. Das Ziel ist es, dass eine Maschine in der gleichen Weise mit Menschen kommunizieren kann, wie es Menschen untereinander bereits seit Jahrhunderten tun.

Somit ist NLU nur ein, wenn auch essenzieller, Teilbereich von NLP, der den Ausgangspunkt dafür bildet, dass die Sprache richtig verstanden wurde. Das bedeutet auch, dass die Qualität von NLP immens davon abhängt, wie gut das Verstehen des Textes war. Auch deshalb liegt vor allem auf dem Textverständnis gerade ein großer Fokus in der Forschung.

Welche Anwendungen nutzen Natural Language Processing?

Die Anwendungsmöglichkeiten für Natural Language Processing sind sehr breit gefächert und es kommen auch in regelmäßigen Abständen neue hinzu. Zu den aktuell verbreitesten Use-Cases gehören:

- Machine Translation, also das automatisierte Übersetzung von einem Text in eine andere Sprache.

- Chatbots bezeichnet eine Schnittstelle für eine automatisierte Kommunikation zwischen einem Menschen und einer Maschine. Dabei muss auf die inhaltlichen Fragestellungen des Menschen eingegangen werden können.

- Text Summarization werden genutzt, um große Textmengen schneller durchforsten zu können, indem lediglich eine geeignete Zusammenfassung gelesen wird. Neueste Modelle, wie beispielsweise GPT-3, können dabei auch verschiedene Zusammenfassungen mit unterschiedlichen Schwierigkeitsleveln erstellen.

Welche Trends zeichnen sich im Bereich des Natural Language Processings ab?

Der Bereich der Verarbeitung natürlicher Sprache (NLP) entwickelt sich rasant, und es gibt mehrere Zukunftstrends, die die Richtung des Bereichs in den kommenden Jahren bestimmen werden. Hier sind einige der wichtigsten Zukunftstrends im NLP:

- Multimodale Interaktion: Bei der multimodalen Interaktion wird eine Kombination von Eingabemethoden wie Sprache und Gesten verwendet, um eine natürlichere und intuitivere Kommunikation zwischen Mensch und Maschine zu ermöglichen. In Zukunft werden NLP-Systeme wahrscheinlich zunehmend multimodal werden und es den Nutzern ermöglichen, auf natürlichere und intuitivere Weise mit Maschinen zu interagieren.

- Deep Learning: Deep Learning ist eine leistungsstarke Technik des maschinellen Lernens, die den Bereich des NLP in den letzten Jahren revolutioniert hat. Deep-Learning-Modelle können lernen, komplexe NLP-Aufgaben wie maschinelle Übersetzung und Stimmungsanalyse mit hoher Genauigkeit durchzuführen. In Zukunft wird Deep Learning wahrscheinlich eine noch größere Rolle spielen, da Forscher neue Modelle und Techniken zur Verbesserung der Leistung und Verkürzung der Trainingszeit entwickeln.

- Neuronale maschinelle Übersetzung: Die neuronale maschinelle Übersetzung (NMT) ist eine Art der maschinellen Übersetzung, bei der neuronale Netze verwendet werden, um Text von einer Sprache in eine andere zu übersetzen. Die NMT hat sich in den letzten Jahren als sehr vielversprechend erwiesen und übertrifft die traditionellen statistischen Verfahren der maschinellen Übersetzung. In Zukunft wird die NMT wahrscheinlich noch genauer und effizienter werden und eine nahtlosere Kommunikation zwischen Menschen ermöglichen, die unterschiedliche Sprachen sprechen.

- Konversationelle KI: Bei der konversationellen KI werden NLP und andere Technologien eingesetzt, um Maschinen in die Lage zu versetzen, natürliche und sinnvolle Unterhaltungen mit Menschen zu führen. Chatbots und virtuelle Assistenten sind in vielen Branchen bereits weit verbreitet und werden in Zukunft wahrscheinlich noch ausgefeilter werden, um komplexere Aufgaben zu bewältigen und individuellere Antworten zu geben.

- Ethische und soziale Überlegungen: In dem Maße, in dem NLP unser tägliches Leben durchdringt, ist es wichtig, die ethischen und sozialen Auswirkungen seiner Nutzung zu berücksichtigen. Fragen wie Voreingenommenheit, Datenschutz und Sicherheit werden in Zukunft wahrscheinlich noch wichtiger werden, und Forscher und Praktiker auf dem Gebiet des NLP werden zusammenarbeiten müssen, um Lösungen zu entwickeln, die fair, transparent und vertrauenswürdig sind.

Dies sind nur einige der zukünftigen Trends im NLP. In dem Maße, wie sich das Feld weiterentwickelt, werden neue Techniken, Werkzeuge und Anwendungen entstehen, die die Art und Weise, wie wir mit Sprache und untereinander interagieren, verändern werden.

Welche ethischen Bedenken gibt es in diesem Bereich?

Der zunehmende Einsatz von Technologien zur Verarbeitung natürlicher Sprache (NLP) hat eine Reihe von ethischen Bedenken aufgeworfen, die von Forschern, Entwicklern und politischen Entscheidungsträgern berücksichtigt werden müssen. Hier sind einige der ethischen Bedenken im Bereich des NLP:

- Voreingenommenheit: Eines der größten ethischen Probleme im NLP ist die mögliche Voreingenommenheit der Daten, die zum Trainieren von maschinellen Lernmodellen verwendet werden. Voreingenommene Daten können zu voreingenommenen Algorithmen und Entscheidungen führen, die die Diskriminierung bestimmter Gruppen von Menschen aufrechterhalten.

- Datenschutz: NLP-Technologien können große Mengen personenbezogener Daten erfassen und analysieren, was Bedenken hinsichtlich des Schutzes der Privatsphäre und des Datenschutzes weckt. Es besteht die Gefahr, dass sensible personenbezogene Daten missbraucht oder falsch gehandhabt werden, was negative Folgen für den Einzelnen und die Gesellschaft als Ganzes haben kann.

- Transparenz: NLP-Algorithmen können komplex und schwer zu interpretieren sein, so dass es schwierig ist, zu verstehen, wie die Entscheidungen getroffen werden. Mangelnde Transparenz kann zu einem Mangel an Vertrauen in NLP-Systeme führen und es schwierig machen, etwaige Verzerrungen oder Fehler zu erkennen und zu beheben.

- Rechenschaftspflicht: Je fortschrittlicher die Technologie wird, desto schwieriger wird es zu bestimmen, wer für die von den Maschinen getroffenen Handlungen und Entscheidungen verantwortlich ist. Dies wirft Fragen zur Verantwortlichkeit und Haftung im Falle von Fehlern, Unfällen oder Schäden auf, die durch NLP-Systeme verursacht werden.

- Fairness: NLP-Systeme sollten so konzipiert sein, dass sie fair und gerecht sind, aber es besteht die Gefahr, dass sie bestehende soziale Ungleichheiten aufrechterhalten oder verschärfen könnten. Es ist wichtig, die möglichen Auswirkungen von NLP-Systemen auf verschiedene Personengruppen zu berücksichtigen und sicherzustellen, dass sie Diskriminierung oder Voreingenommenheit nicht verstärken.

Dies sind nur einige der ethischen Bedenken im Bereich des NLP. Da die NLP-Technologie weiter voranschreitet und immer häufiger eingesetzt wird, ist es wichtig, sich mit diesen Bedenken auseinanderzusetzen und Lösungen zu entwickeln, die Fairness, Transparenz und Verantwortlichkeit in den Vordergrund stellen.

Das solltest Du mitnehmen

- Natural Language Processing ist ein Teilbereich der Computer Science, der versucht natürliche Sprache für Maschinen verständlich und verarbeitbar zu machen.

- Die Python Module spaCy und NLTK sind die Grundbausteine für die meisten Applikationen.

- Es ist eines der aktuellsten Themen im Bereich des Machine Learnings und erfährt viele neue Innovationen.

Was ist eine Boltzmann Maschine?

Die Leistungsfähigkeit von Boltzmann Maschinen freisetzen: Von der Theorie zu Anwendungen im Deep Learning und deren Rolle in der KI.

Was ist die Gini-Unreinheit?

Erforschen Sie die Gini-Unreinheit: Eine wichtige Metrik für die Gestaltung von Entscheidungsbäumen beim maschinellen Lernen.

Was ist die Hesse Matrix?

Erforschen Sie die Hesse Matrix: Ihre Mathematik, Anwendungen in der Optimierung und maschinellen Lernen.

Was ist Early Stopping?

Beherrschen Sie die Kunst des Early Stoppings: Verhindern Sie Overfitting, sparen Sie Ressourcen und optimieren Sie Ihre ML-Modelle.

Was sind Gepulste Neuronale Netze?

Tauchen Sie ein in die Zukunft der KI mit Gepulste Neuronale Netze, die Präzision, Energieeffizienz und bioinspiriertes Lernen neu denken.

Was ist RMSprop?

Meistern Sie die RMSprop-Optimierung für neuronale Netze. Erforschen Sie RMSprop, Mathematik, Anwendungen und Hyperparameter.

Andere Beiträge zum Thema Natural Language Processing

- In diesem Beitrag findest Du eine Liste von kostenlosen Tools mit welchen man direkt online Natural Language Processing Aufgaben umsetzen kann.

Niklas Lang

Seit 2020 bin ich als Machine Learning Engineer und Softwareentwickler tätig und beschäftige mich leidenschaftlich mit der Welt der Daten, Algorithmen und Softwareentwicklung. Neben meiner Arbeit in der Praxis unterrichte ich an mehreren deutschen Hochschulen, darunter die IU International University of Applied Sciences und die Duale Hochschule Baden-Württemberg, in den Bereichen Data Science, Mathematik und Business Analytics.

Mein Ziel ist es, komplexe Themen wie Statistik und maschinelles Lernen so aufzubereiten, dass sie nicht nur verständlich, sondern auch spannend und greifbar werden. Dabei kombiniere ich praktische Erfahrungen aus der Industrie mit fundierten theoretischen Grundlagen, um meine Studierenden bestmöglich auf die Herausforderungen der Datenwelt vorzubereiten.