Apache Flink ist ein open-source, verteiltes Hochleistungs-Computing-Framework, das für die Verarbeitung großer Datenströme und Batchdaten entwickelt wurde. Es ist bekannt für seine Fähigkeit, große Datenmengen zu verarbeiten und dabei niedrige Latenzzeiten und einen hohen Durchsatz beizubehalten. Flink basiert auf dem Konzept der Datenflussprogrammierung, bei der ein Programm als gerichteter Graph von Datentransformationen dargestellt wird, die parallel ausgeführt werden können.

Flink unterstützt eine breite Palette von Datenquellen und -senken, darunter Apache Kafka, Apache Hadoop und Amazon S3, und ist damit ein vielseitiges Tool für die Datenverarbeitung und -analyse. Flink wurde ursprünglich von der Apache Software Foundation im Jahr 2014 entwickelt und hat seitdem eine breite Akzeptanz bei verschiedenen Organisationen für Anwendungsfälle wie Echtzeitanalysen, Betrugserkennung und maschinelles Lernen gefunden.

Wie sieht die Architektur von Flink aus?

Apache Flink ist eine verteilte Open-Source-Verarbeitungs-Engine, die für die Unterstützung von Stapelverarbeitung und Stream-Verarbeitung entwickelt wurde. Die Architektur von Apache Flink umfasst mehrere Schichten, die zusammenarbeiten, um eine effiziente und fehlertolerante Datenverarbeitung zu ermöglichen.

Das Herzstück von Apache Flink ist die Datenverarbeitungs-Engine, die eine verteilte Datenfluss-Engine umfasst, die sowohl Batch- als auch Stream-Verarbeitung verarbeiten kann. Die Engine ist für die Verteilung der Datenverarbeitungsaufgaben auf einen Cluster von Maschinen, die Verwaltung der Datenströme und die Fehlertoleranz verantwortlich.

Oberhalb der Datenverarbeitungs-Engine gibt es zwei Hauptschichten in der Apache Flink-Architektur: die APIs und die Laufzeitkomponenten. Die API-Schicht bietet eine Vielzahl von Programmierschnittstellen für Benutzer zum Schreiben von Datenverarbeitungsanwendungen, einschließlich Stapelverarbeitungs-APIs, Stream-Verarbeitungs-APIs und Tabellen-APIs. Diese APIs sind so konzipiert, dass sie intuitiv und einfach zu bedienen sind, aber dennoch leistungsstarke Funktionen für fortgeschrittene Benutzer bieten.

Die Laufzeitkomponentenschicht umfasst verschiedene Module, die für die Ausführung der Datenverarbeitungsanwendungen auf dem Cluster verantwortlich sind. Zu diesen Komponenten gehören der JobManager, der TaskManager und der ResourceManager. Der JobManager ist für die Planung von Aufträgen, die Koordinierung der verteilten Ausführung von Aufgaben und die Bereitstellung von Fehlertoleranz zuständig. Der TaskManager ist für die Ausführung der einzelnen Aufgaben zuständig, die ihm vom JobManager zugewiesen wurden, und der ResourceManager verwaltet die Ressourcen des Clusters und weist den Aufgaben bei Bedarf Ressourcen zu.

Insgesamt ist die Architektur von Apache Flink auf hohe Flexibilität und Skalierbarkeit ausgelegt, sodass Benutzer große Datenmengen schnell und effizient verarbeiten können und gleichzeitig Fehlertoleranz und Zuverlässigkeit erhalten bleiben.

Was sind die Hauptmerkmale von Apache Flink?

Apache Flink ist ein verteiltes Stream-Processing-Framework mit einer Vielzahl von Funktionen, die es für verschiedene Anwendungsfälle geeignet machen. Einige der wichtigsten Funktionen von Apache Flink sind:

- Stream- und Batch-Verarbeitung: Flink unterstützt sowohl Stream- als auch Batch-Verarbeitung und ermöglicht es Entwicklern, Datenverarbeitungsanwendungen zu erstellen, die sowohl Echtzeit-Datenströme als auch Batch-Datenverarbeitung verarbeiten können.

- Fehlertoleranz: Apache Flink bietet eine fehlertolerante Laufzeit, die Maschinen- und Anwendungsausfälle ohne Daten- oder Fortschrittsverlust bewältigen kann. Das System erholt sich automatisch von Ausfällen und minimiert so Ausfallzeiten und Datenverluste.

- Hoher Durchsatz und niedrige Latenzzeit: Flink ist für die Verarbeitung von Datenströmen mit hohem Durchsatz und geringer Latenz konzipiert. Das Framework ist für die Verarbeitung mit geringer Latenz optimiert und ermöglicht Verarbeitungslatenzen von weniger als einer Millisekunde.

- Ereigniszeitverarbeitung: Flink unterstützt die Verarbeitung von Datenströmen auf der Grundlage der Ereigniszeit und nicht der Verarbeitungszeit, was für die korrekte Verarbeitung von Daten außerhalb der Reihenfolge und die Verarbeitung von verspäteten Daten unerlässlich ist.

- Zustandsabhängige Stream-Verarbeitung: Flink ermöglicht es Entwicklern, den Zustand von Datenströmen aufrechtzuerhalten, was für verschiedene Anwendungsfälle wie Sitzungsfenster, Betrugserkennung usw. unerlässlich ist.

- Dynamische Skalierung: Flink bietet dynamische Skalierungsfunktionen, die es Entwicklern ermöglichen, dem Cluster bei Bedarf Ressourcen hinzuzufügen oder zu entfernen, je nach Arbeitslast.

- Umfangreiche APIs und Bibliotheken: Flink bietet eine Vielzahl von APIs und Bibliotheken für die Datenverarbeitung, darunter Java- und Scala-APIs, SQL und Bibliotheken für maschinelles Lernen wie FlinkML.

- Integrationen: Flink lässt sich mit verschiedenen externen Systemen wie Apache Kafka, Apache Cassandra, Apache Hadoop und anderen integrieren, was den Aufbau von End-to-End-Datenverarbeitungspipelines erleichtert.

Diese Funktionen machen Apache Flink zu einem vielseitigen und leistungsstarken Framework für den Aufbau komplexer Datenverarbeitungsanwendungen, die eine niedrige Latenzzeit erfordern.

Wie ist Flink mit anderen Datenverarbeitungswerkzeugen integriert?

Apache Flink ist so konzipiert, dass es nahtlos mit einer Vielzahl anderer Datenverarbeitungstools und -technologien zusammenarbeitet. Nachfolgend sind einige der üblichen Möglichkeiten aufgeführt, wie Apache Flink in andere Tools integriert werden kann:

- Apache Kafka: Apache Kafka ist eine beliebte verteilte Streaming-Plattform, die häufig mit Apache Flink verwendet wird. Flink kann Daten aus Kafka-Themen lesen und auch Daten zurück nach Kafka schreiben. So lassen sich mit Kafka und Flink problemlos End-to-End-Pipelines für Streaming-Daten erstellen.

- Apache Hadoop: Apache Flink kann auch mit Apache Hadoop integriert werden, einem beliebten Big-Data-Verarbeitungsframework. Flink kann Daten in HDFS (Hadoop Distributed File System) lesen und schreiben und kann auch MapReduce-Aufträge auf Hadoop ausführen.

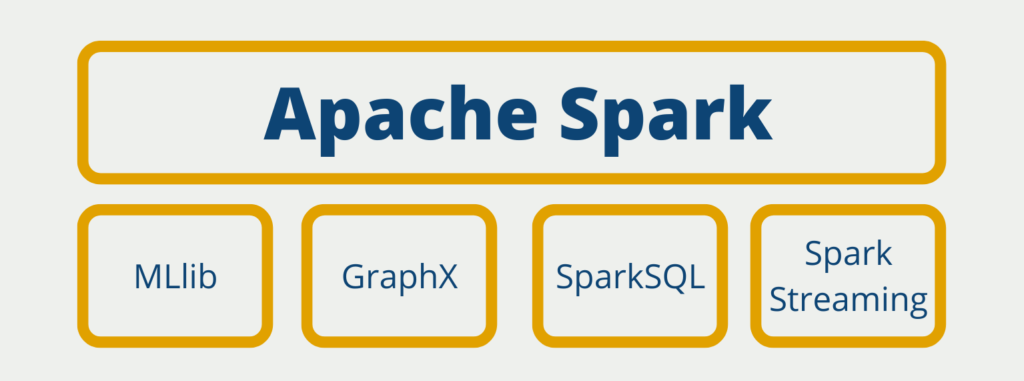

- Apache Spark: Apache Spark ist ein weiteres beliebtes Big-Data-Verarbeitungs-Framework, das mit Apache Flink integriert werden kann. Sowohl Spark als auch Flink können Daten in Hadoop HDFS lesen und schreiben und sie können auch Daten im Apache Arrow-Format gemeinsam nutzen.

- Apache NiFi: Apache NiFi ist ein Datenintegrationstool, das eine webbasierte Schnittstelle für die Gestaltung und Verwaltung von Datenflüssen bietet. Apache Flink kann Daten aus NiFi lesen und sie in Echtzeit verarbeiten.

- Apache Beam: Apache Beam ist ein einheitliches Programmiermodell für die Batch- und Streaming-Datenverarbeitung. Apache Flink kann Apache Beam-Pipelines nativ ausführen, so dass die Benutzer die Vorteile der Portabilität und Flexibilität von Beam nutzen können.

- SQL: Apache Flink bietet auch eine SQL-API, mit der Benutzer SQL-Abfragen schreiben können, um Daten in Echtzeit zu analysieren. Die SQL-API unterstützt sowohl Standard-SQL-Abfragen als auch komplexe Ereignisverarbeitungsabfragen (CEP).

Dank dieser Integrationen kann Apache Flink in einer Vielzahl von Anwendungsfällen der Datenverarbeitung eingesetzt werden, darunter Datenverarbeitung in Echtzeit, maschinelles Lernen und ETL-Pipelines (Extract, Transform, Load).

Wie leistungsfähig ist Apache Flink?

Apache Flink wurde entwickelt, um effiziente und leistungsstarke Datenverarbeitungsfunktionen für Big-Data-Anwendungen bereitzustellen. Einige der Funktionen, mit denen Flink eine hohe Leistung erreicht, sind:

- Streaming-First-Architektur: Flink verfügt über eine Streaming-First-Architektur, d. h. es ist darauf ausgelegt, Datenströme effizient zu verarbeiten. Es verwendet eine Datenfluss-Engine, die Daten auf kontinuierliche und inkrementelle Weise verarbeitet.

- Speicherverwaltung: Das Speichermanagement von Flink ist für die Verarbeitung großer Datenmengen optimiert. Es verwendet einen hybriden Speicherverwaltungsansatz, der verwalteten Speicher und externen Speicher kombiniert.

- Verkettung von Operatoren: Flink optimiert die Datenverarbeitung, indem es mehrere Operatoren miteinander verkettet und als eine Einheit ausführt. Dadurch wird der Overhead bei der Serialisierung und Deserialisierung von Daten reduziert.

- Zustandsabhängige Stream-Verarbeitung: Flink unterstützt zustandsbehaftete Stream-Verarbeitung, die es ermöglicht, den Zustand über verschiedene Verarbeitungsfenster hinweg zu erhalten. Dies ermöglicht Flink die Durchführung komplexer Verarbeitungsvorgänge für Streaming-Daten.

- Fehlertoleranz: Flink bietet eine fehlertolerante Laufzeit, die Knotenausfälle und Netzwerkprobleme bewältigen kann. Es verwendet einen Checkpointing-Mechanismus, der den Zustand der laufenden Anwendung regelmäßig in einem dauerhaften Speichersystem speichert.

- Native Stapelverarbeitung: Flink verfügt über einen nativen Batch-Verarbeitungsmodus, der sowohl Batch- als auch Streaming-Aufträge verarbeiten kann. Dies bietet einen einheitlichen Verarbeitungsrahmen für beide Arten von Workloads.

- Dynamische Skalierung: Flink bietet eine dynamische Skalierung der Ressourcen, um unterschiedliche Arbeitslasten zu bewältigen. Sie kann je nach den Verarbeitungsanforderungen der Anwendung nach oben oder unten skaliert werden.

Insgesamt ist die Leistung von Flink sehr konkurrenzfähig mit anderen beliebten Big-Data-Verarbeitungs-Frameworks wie Apache Spark und Apache Storm. Seine Streaming-First-Architektur und die optimierte Speicherverwaltung machen es zu einer hervorragenden Wahl für Hochleistungs-Datenverarbeitungsanwendungen.

Was sind die Anwendungsbereiche von Apache Flink?

Apache Flink ist ein leistungsfähiges Datenverarbeitungs-Framework, das branchenübergreifend in verschiedenen Anwendungsfällen eingesetzt wurde. Hier sind einige Beispiele für den Einsatz von Apache Flink:

- Stream-Verarbeitung: Flink wurde für die Stream-Verarbeitung in Echtzeit in einer Vielzahl von Branchen eingesetzt, darunter Finanzen, Telekommunikation und eCommerce. So kann Flink beispielsweise dazu verwendet werden, betrügerische Transaktionen in Echtzeit zu erkennen oder Kunden auf der Grundlage ihres Surfverhaltens Echtzeitempfehlungen zu geben.

- Stapelverarbeitung: Flink eignet sich auch gut für die Stapelverarbeitung, insbesondere bei großen Datenmengen. Flink kann für die Verarbeitung von Daten in Stapeln verwendet werden, z. B. für Data Warehousing und ETL-Aufgaben (Extrahieren, Transformieren, Laden).

- Maschinelles Lernen: Flink unterstützt auch Bibliotheken für maschinelles Lernen, wie z. B. FlinkML, mit denen Benutzer maschinelle Lernmodelle auf großen Datensätzen in einer verteilten Umgebung erstellen können.

- IoT: Flink wurde auch in Internet of Things (IoT)-Anwendungen eingesetzt, wo es zur Verarbeitung von Datenströmen von Sensoren und anderen Geräten in Echtzeit verwendet werden kann.

- Datenanalyse: Flink kann für verschiedene Anwendungsfälle der Datenanalyse eingesetzt werden, z. B. Datenvisualisierung in Echtzeit, Datenaggregation und Anomalieerkennung.

- Datenintegration: Flink kann auch für die Datenintegration verwendet werden, z. B. für die Datenmigration und -synchronisation, wenn Daten von einem System auf ein anderes übertragen werden müssen.

Insgesamt ist Apache Flink ein vielseitiges Framework, das in einer Vielzahl von Anwendungsfällen eingesetzt werden kann, in denen eine schnelle, skalierbare und fehlertolerante Datenverarbeitung erforderlich ist.

Das solltest Du mitnehmen

- Apache Flink ermöglicht die Verarbeitung massiver Datenströme in Echtzeit und bietet Funktionen mit niedriger Latenz und hohem Durchsatz.

- Die fehlertolerante Architektur von Flink gewährleistet eine zuverlässige und konsistente Verarbeitung auch bei Ausfällen.

- Das flexible Programmiermodell von Flink ermöglicht es Entwicklern, komplexe Datenverarbeitungspipelines einfach zu schreiben.

- Die Unterstützung von Flink für Ereigniszeitverarbeitung und Windowing ermöglicht die Verarbeitung von Daten außerhalb der Reihenfolge und zeitbasierte Aggregationen.

- Die umfassende Integration von Flink in ein Ökosystem mit Tools wie Apache Kafka und Apache Hadoop macht es zu einer vielseitigen Wahl für verschiedene Datenverarbeitungsszenarien.

- Das umfangreiche Angebot an Konnektoren, Bibliotheken und APIs von Flink vereinfacht die Integration mit anderen Systemen und erweitert die Funktionalität.

- Die Skalierbarkeit von Flink ermöglicht den nahtlosen Umgang mit wachsenden Datenmengen und Verarbeitungsanforderungen.

- Die von der Community betriebene Entwicklung und die aktive Benutzerbasis von Flink gewährleisten eine kontinuierliche Verbesserung und Unterstützung.

Was ist die Univariate Analyse?

Univariate Analyse beherrschen: Mit Visualisierung und Python tief in Daten eintauchen - Lernen Sie anhand von praktischem Code.

Was ist OpenAPI?

Erkunden Sie OpenAPI: Ein Leitfaden zum Aufbau und zur Nutzung von RESTful APIs. Lernen Sie, wie man APIs entwirft und dokumentiert.

Was ist Data Governance?

Sichern Sie die Qualität, Verfügbarkeit und Integrität der Daten Ihres Unternehmens durch effektives Data Governance. Erfahren Sie mehr.

Was ist Datenqualität?

Sicherstellung der Datenqualität: Bedeutung, Herausforderungen und bewährte Praktiken. Erfahren Sie, wie Sie hochwertige Daten erhalten.

Was ist die Datenimputation?

Imputieren Sie fehlende Werte mit Datenimputationstechniken. Optimieren Sie die Datenqualität und erfahren Sie mehr über die Techniken.

Was ist Ausreißererkennung?

Entdecken Sie Anomalien in Daten mit Verfahren zur Ausreißererkennung. Verbessern Sie ihre Entscheidungsfindung!

Andere Beiträge zum Thema Apache Flink

Die offizielle Website von Apache Flink finden Sie hier.

Niklas Lang

Seit 2020 bin ich als Machine Learning Engineer und Softwareentwickler tätig und beschäftige mich leidenschaftlich mit der Welt der Daten, Algorithmen und Softwareentwicklung. Neben meiner Arbeit in der Praxis unterrichte ich an mehreren deutschen Hochschulen, darunter die IU International University of Applied Sciences und die Duale Hochschule Baden-Württemberg, in den Bereichen Data Science, Mathematik und Business Analytics.

Mein Ziel ist es, komplexe Themen wie Statistik und maschinelles Lernen so aufzubereiten, dass sie nicht nur verständlich, sondern auch spannend und greifbar werden. Dabei kombiniere ich praktische Erfahrungen aus der Industrie mit fundierten theoretischen Grundlagen, um meine Studierenden bestmöglich auf die Herausforderungen der Datenwelt vorzubereiten.