Der Bias-Variance Tradeoff beschreibt ein grundlegendes Problem im Machine Learning, welches besagt, dass man einen Kompromiss eingehen muss zwischen einem möglichst einfachen Modell und einem sehr anpassungsfähigen Modell, das gute Ergebnisse auch für neue Daten liefert.

Bei jedem Training stehen die zwei zentralen Aspekte Bias und Varianz im Konflikt. Bevor wir uns diese Problematik genauer anschauen können, sollten wir verstehen was der Bias und die Varinaz genau sind.

Was ist der Bias und die Varianz?

Der Bias, oder auf deutsch Verzerrung, beschreibt das Problem, dass ein zu einfaches Modell die zugrundeliegenden Strukturen in den Daten nicht erkennt und deshalb immer abweichende Werte vorhersagt und somit ein gewisser Restfehler bleibt. Jedoch will man im Training das Modell auch nicht zu komplex bauen, um ein Overfitting zu verhindern, was wiederum eine schlechte Generalisierung auf ungesehene Daten bedeuten würde.

Beim Training eines Modells zur Vorhersage der verkauften Eismenge abhängig von der Außentemperatur kann es zu einer Verzerrung kommen, wenn man einen linearen Zusammenhang vermutet. Angenommen ein solches Modell würde einen Wert von 0,7 Kugeln pro Grad Celsius Temperaturerhöhung errechnen. Das würde jedoch bedeuten, dass man bei einer Temperaturerhöhung von 5 °C 3,5 Kugeln mehr konsumiert, egal ob diese Temperaturerhöhung von 20 °C auf 25 °C stattgefunden hat oder von 30 °C auf 35 °C. Dieses Modell ist eindeutig zu einfach, da der Konsum vielmehr eine exponentielle Kurve annimmt, also bei höheren, zweistelligen Temperaturen der Eiskonsum deutlich stärker zunimmt als bei niedrigeren, einstelligen Temperaturen.

Ein solches Modell mit einem linearen Zusammenhang hat also eine klare Verzerrung, da es zu einfach ist und somit den wahren Zusammenhang zwischen Außentemperatur und Eiskonsum nicht richtig abbilden kann. Dadurch lassen sich keine genauen Prognosen für den Eiskonsum treffen.

Die Varianz hingegen beschreibt, wie stark die Vorhersagen eines Modells schwanken, wenn sich die Eingabewerte nur minimal ändern. Eine hohe Varianz würde bedeuten, dass leichte Änderungen beim Input zu sehr starken Änderungen der Vorhersagen führen würden. Ein Modell mit einer hohen Varianz würde also beispielsweise eine Eismenge von zwei Kugeln bei einer Temperatur von 28 °C vorhersagen und eine Eismenge von drei Kugeln bei einer Außentemperatur von 28,5 °C.

Was ist der Bias-Variance Tradeoff?

Ein gutes Machine Learning Modell sollte eine möglichst geringe Varianz haben, damit leichte Änderungen nur geringe Auswirkungen auf die Vorhersagen haben und das Modell somit zuverlässige und belastbare Vorhersagen liefert. Gleichzeitig sollte jedoch auch die Verzerrung gering sein, sodass die Vorhersage möglichst nahe am tatsächlichen Ergebnis liegt. Das problematische an diesem Ziel ist nun jedoch, dass ein Modell mit einem geringen Bias eine hohe Varianz zur Folge hat und umgekehrt.

Dadurch ergibt sich der Gewissenskonflikt, der mit dem Bias-Variance Tradeoff zusammengefasst wird. Um einen geringeren Bias zu erzielen, muss das Modell komplexer werden, was jedoch wiederum zu einem potenziellen Overfitting und einer höheren Varianz führt. Im umgekehrten Fall kann die Varianz vermindert werden, indem die Komplexität des Modells reduziert wird, was jedoch wieder einen steigenden Bias zur Folge hat.

Die Kunst besteht nun darin, einen guten Kompromiss zwischen einem vertretbaren Maß an Verzerrung und einem vertretbaren Maß an Varianz zu finden. Es ist wichtig diesen grundlegenden Zusammenhang zu verstehen, um diesen in allen Bereichen des Modelltrainings zu berücksichtigen und zu integrieren.

Welche Szenarien können beim Modelltraining auftreten?

In der Realität ergeben sich aus dieser Abhängigkeit insgesamt vier Szenarien, die auftreten können:

- Geringe Varianz, Geringer Bias: Ein optimales Machine Learning Modell kombiniert eine geringe Varianz mit einem geringen Bias. In diesem Fall liefert das Modell genaue Vorhersagen, sowohl für die Trainingsdaten als auch für neue, ungesehene Daten.

- Hohe Varianz, Geringer Bias: Bei einem geringen Bias sind die Vorhersagen sehr genau, jedoch bedeutet eine hohe Varianz, dass die Vorhersagen stark schwanken und auf kleine Veränderungen stark reagieren. Ein solches Modell leidet an Overfitting und hat sich zu stark auf die Trainingsdaten angepasst und liefert nur schlechte Vorhersagen für neue Werte.

- Geringe Varianz, Hoher Bias: Ein Modell mit diesen Eigenschaften leidet an Underfitting, da die Vorhersagen des Modells zwar konstant sind, aber aufgrund des Bias auch sehr ungenau und nicht nahe am tatsächlichen Wert liegen. In einem solchen Fall sollte ein komplexeres Modell gewählt werden, das in der Lage ist, die Strukturen in den Daten zu erkennen.

- Hohe Varianz, Hohe Verzerrung: Ein solches Modell ist einfach komplett unzureichend und die Modellarchitektur wurde falsch gewählt. Am besten sollte komplett neu gestartet werden, um eine bessere Modellstruktur zu finden.

In der Praxis gilt es die vorgestellten Szenarien zu unterscheiden und entsprechend zu reagieren. In vielen Fällen trifft man auf Szenario zwei oder drei und muss gezielt daran arbeiten, in Richtung Szenario eins zu kommen.

Welche Methoden gibt es, um mit dem Bias-Variance Tradeoff umzugehen?

Es gibt unterschiedliche Ansätze um dem Bias-Variance Tradeoff zu begegnen. Unter anderem spielt die Auswahl der Inputparameter eine wichtige Rolle. Eine hohe Zahl an Inputvariablen erhöht die Komplexität des Modells und somit das Risiko eine hohe Varianz zu erzeugen. Jedoch hängen möglicherweise verschiedene Inputparameter miteinander zusammen, wie in dem genannten Modell zum Eiskonsum die Inputparameter Außentemperatur und Luftfeuchtigkeit, und können zusammengefasst werden. Durch dieses sogenannte Feature Engineering kann die Komplexität des Modells verringert werden, ohne dass wichtige Informationen für die Vorhersage verloren gehen.

Eine andere Möglichkeit, um den Bias-Variance Tradeoff im Trainingsprozess zu berücksichtigen ist die Auswahl des Modells. Bestimmte Modelle, die auch auf dieser Website vorgestellt werden, sind bekannt dafür, dass sie Ergebnisse mit hohen Varianzen liefern. Diese Eigenschaft sollte bei der Modellauswahl bedacht werden.

Außerdem können die folgenden Werkzeuge genutzt werden:

- Regularisierung: Bei der Regularisierung wird ein Strafterm in das Modelltraining mit eingeführt, um zu verhindern, dass sich das Modell zu sehr an die Trainingsdaten anpasst und es dadurch zu Overfitting kommt. Dadurch hat die Regularisierung auch einen Einfluss auf die Varianz und den Bias.

- Cross-Validation: Mithilfe der Cross-Validation kann der Datensatz effizient in Trainings- und Testdatensatz aufgeteilt werden. Dadurch ist es möglich, dass frühzeitig erkannt wird, ob sich das Modell zu stark an die Trainingsdaten anpasst, und es können die Hyperparameter entsprechend verändert werden.

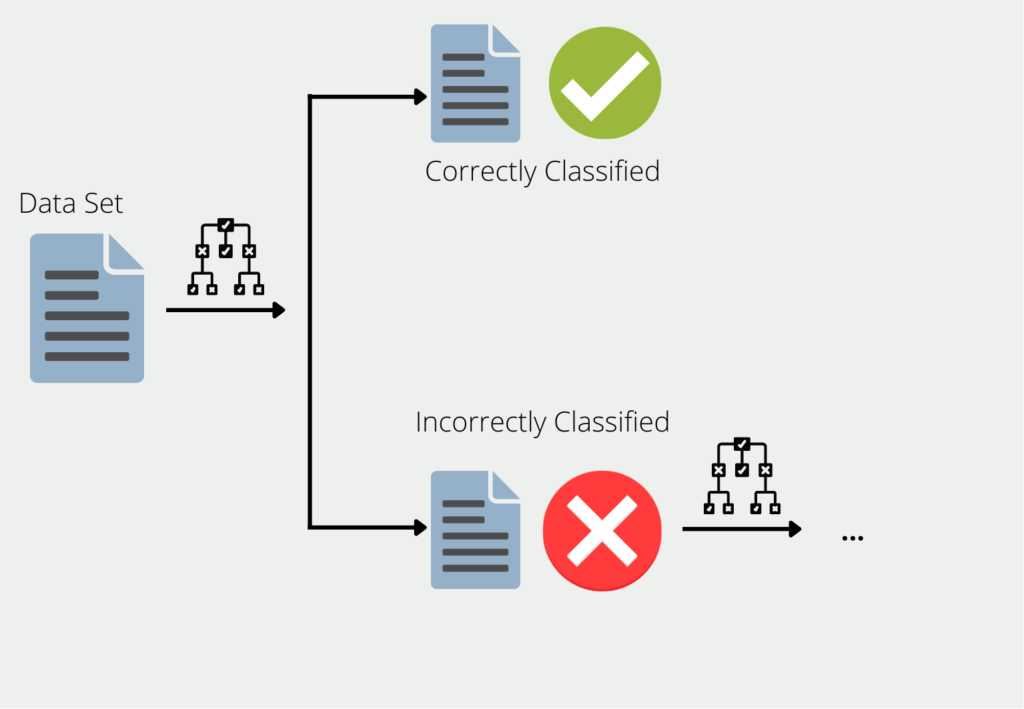

- Ensemble-Modelle: Beim Ensemble Training werden mehrere Modelle mit ähnlichen Daten trainiert. Dabei wird das sogenannte Bagging und Boosting verwendet. Beim Bagging werden verschiedene Modelle auf Teilmengen des Datensatzes trainiert und die Vorhersage des Ensembles ist dann der Durchschnitt der Vorhersagen aus den Teilmodellen. Beim Boosting hingegen werden die Modelle nacheinander trainiert und das nachfolgende Modell gewichtet dann die Daten stärker, die das vorherige Modell falsch vorhergesagt hat. Durch diese Kombination verringert sich die Varianz deutlich.

In diesem Abschnitt wurden einige Möglichkeiten vorgestellt, um mit dem Bias-Variance Tradeoff umzugehen. Diese müssen für den konkreten Anwendungsfall bewertet werden, um ein optimales Ergebnis erzielen zu können.

In welchen Anwendungen spielt der Bias-Variance Tradeoff eine Rolle?

Der Bias-Variance Tradeoff spielt in den meisten Anwendungen eine Rolle und sollte immer im Hinterkopf behalten werden, da es einen zentralen Einfluss auf die Vorhersagequalität hat. Zu den prominentesten Anwendungen, die mit dieser Problematik zu kämpfen haben, zählen beispielsweise:

Bilderkennung: In diesem Bereich ist es besonders schwierig den Punkt zu finden an dem ein Modell komplex genug ist, um alle Merkmale in einem Bild richtig zu erkennen und sich trotzdem nicht zu sehr auf die Trainingsdaten einschießt, sodass es schlechte Ergebnisse für neue Daten liefert.

Medizinische Diagnose: Hierbei wird versucht, anhand von Eigenschaften eines Patienten vorherzusagen, ob die Person erkrankt ist oder nicht. Hierbei ist es wichtig, eine möglichst geringe Verzerrung zu erreichen, da eine falsche Vorhersage in der Realität immense Folgen haben kann. Trotzdem sollte die Varianz im Auge behalten werden, um nicht zu sensibel auf leichte Veränderungen in den Daten zu reagieren.

Vorhersage des Aktienmarktes: In dieser Anwendung gilt es Modelle mit einer geringen Verzerrung zu finden, damit wichtige Signale in den Aktienkursen nicht übersehen werden. Gleichzeitig sollte jedoch auch die Varianz gering sein, damit die Vorhersagen nicht zu stark schwanken, wodurch sich das Risiko des Investments deutlich erhöht.

Verarbeitung natürlicher Sprache: Im Bereich der natürlichen Sprachverarbeitung (NLP) werden genauso wie in der Bilderkennung sehr komplexe Modelle benötigt, die viele trainierbare Parameter besitzen. Deshalb haben diese Architekturen einen Hang zum Overfitting, was in einer erhöhten Varianz mündet. Deshalb spielen bei dieser Anwendung ein ausreichendes Hyperparameter Tuning eine wichtige Rolle.

Dies sind nur einige ausgewählte Anwendungen in denen der Bias-Variance Tradeoff auftritt. Wichtig ist bei jedem Projekt die Problematik im Hinterkopf zu behalten und während dem Training entsprechende Maßnahmen zu ergreifen, um sowohl den Bias als auch die Varianz im Griff zu behalten.

Das solltest Du mitnehmen

- Der Bias-Variance Tradeoff beschreibt die Problematik, dass beim Training von Machine Learning Modellen der Bias und die Varianz in einem Gegenwicht zueinanderstehen. Ein Modell mit einer geringeren Varianz resultiert in einem höheren Bias und umgekehrt.

- Bei einer hohen Verzerrung ist das Modell nicht komplex genug, um die Strukturen in den Daten zu erkennen und liefert deshalb durchgehend falsche Vorhersagen.

- Bei einer hohen Varianz hingegen reagiert das Modell zu stark auf kleinste Veränderungen in den Daten, sodass die Vorhersagen sehr stark schwanken.

- Das Ziel besteht nun darin eine Modellarchitektur zu finden, die ein niedriges Level an Bias mit einer niedrigen Varianz kombiniert. In der Praxis kann es sehr schwierig sein diesen Zustand zu erreichen.

- Zur Bekämpfung des Bias-Variance Tradeoffs können beispielsweise das Feature Engineering oder eine geeignete Modellauswahl genutzt werden.

- Der Bias-Variance Tradeoff spielt eigentlich in jeder Machine Learning Anwendung eine Rolle, jedoch kann diese Problematik mal stärker und mal schwächer ausgeprägt sein.

Was ist eine Boltzmann Maschine?

Die Leistungsfähigkeit von Boltzmann Maschinen freisetzen: Von der Theorie zu Anwendungen im Deep Learning und deren Rolle in der KI.

Was ist die Gini-Unreinheit?

Erforschen Sie die Gini-Unreinheit: Eine wichtige Metrik für die Gestaltung von Entscheidungsbäumen beim maschinellen Lernen.

Was ist die Hesse Matrix?

Erforschen Sie die Hesse Matrix: Ihre Mathematik, Anwendungen in der Optimierung und maschinellen Lernen.

Was ist Early Stopping?

Beherrschen Sie die Kunst des Early Stoppings: Verhindern Sie Overfitting, sparen Sie Ressourcen und optimieren Sie Ihre ML-Modelle.

Was sind Gepulste Neuronale Netze?

Tauchen Sie ein in die Zukunft der KI mit Gepulste Neuronale Netze, die Präzision, Energieeffizienz und bioinspiriertes Lernen neu denken.

Was ist RMSprop?

Meistern Sie die RMSprop-Optimierung für neuronale Netze. Erforschen Sie RMSprop, Mathematik, Anwendungen und Hyperparameter.

Andere Beiträge zum Thema Bias-Variance Tradeoff

Die Cornell University bietet eine interessante Vorlesung zu dem Bias-Variance Tradeoff an.

Niklas Lang

Seit 2020 bin ich als Machine Learning Engineer und Softwareentwickler tätig und beschäftige mich leidenschaftlich mit der Welt der Daten, Algorithmen und Softwareentwicklung. Neben meiner Arbeit in der Praxis unterrichte ich an mehreren deutschen Hochschulen, darunter die IU International University of Applied Sciences und die Duale Hochschule Baden-Württemberg, in den Bereichen Data Science, Mathematik und Business Analytics.

Mein Ziel ist es, komplexe Themen wie Statistik und maschinelles Lernen so aufzubereiten, dass sie nicht nur verständlich, sondern auch spannend und greifbar werden. Dabei kombiniere ich praktische Erfahrungen aus der Industrie mit fundierten theoretischen Grundlagen, um meine Studierenden bestmöglich auf die Herausforderungen der Datenwelt vorzubereiten.